Pour améliorer Siri, Apple fait appel à des sous-traitants chargés d'écouter des extraits audio captés auprès d'utilisateurs. Une pratique qui est celle de toute l'industrie : Amazon et Google emploient aussi ces petites oreilles discrètes… et parfois indiscrètes. Dans le cas d'Apple, c'est bien plus embêtant en raison de la position très ferme de l'entreprise sur la confidentialité des données.

Une source de ces sous-traitants a évoqué son travail et ses inquiétudes auprès du Guardian. Il n'est en effet pas rare d'entendre des conversations très privées qui, manifestement, n'étaient pas destinées à Siri. Vente de drogue, discussions autour d'un contrat commercial, et même des couples qui font l'amour, c'est arrivé plus d'une fois.

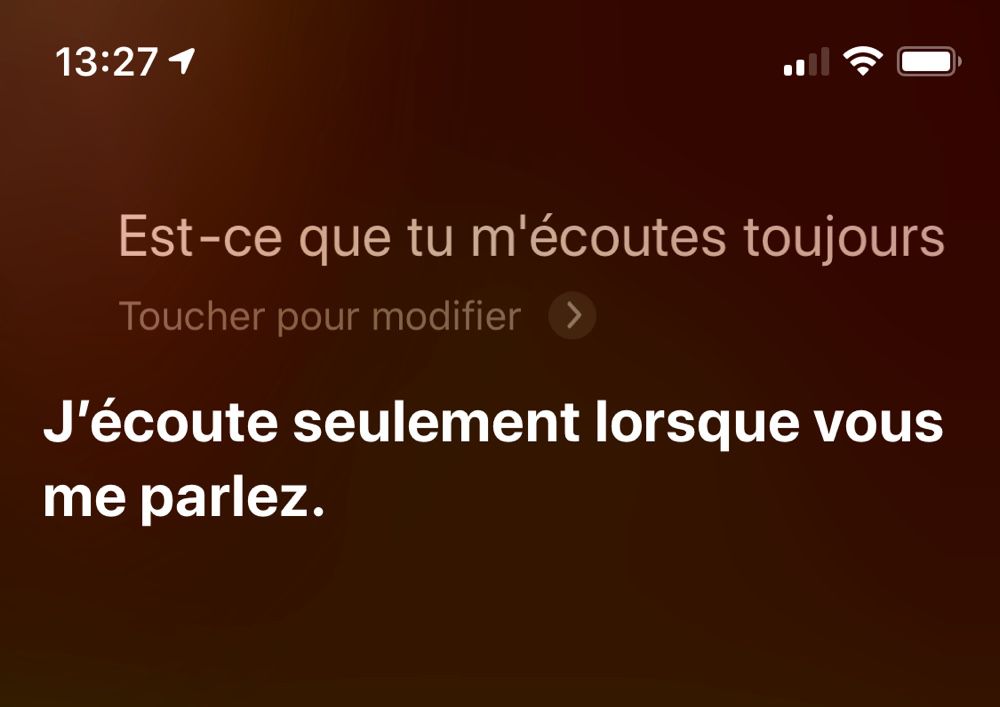

Siri n'est pas censé écouter aux portes. L'assistant ne se lance qu'après avoir entendu son déclencheur, « Dis Siri ». Or, il est assez fréquent que l'assistant s'active par accident. Sur l'Apple Watch il n'est même plus utile de le convoquer, il suffit de porter la montre à sa bouche puis de parler1. Le sous-traitant explique d'ailleurs que les extraits audio accidentels proviennent souvent de l'Apple Watch et du HomePod.

« La régularité des déclencheurs accidentels avec la montre est incroyablement élevée », détaille cette source. « [L'Apple Watch] peut enregistrer des extraits de 30 secondes. Ce n'est pas si long, mais vous pouvez avoir une bonne idée de ce qui se passe ».

Parfois, on entend un docteur parler de l'historique médical d'un patient. Ou vous pouvez entendre quelqu'un, avec un bruit de moteur au fond, en train de dealer de la drogue. Et vous pouvez aussi écouter des gens en train de faire l'amour, et qui s'enregistrent accidentellement sur le HomePod ou la montre.

S'il est possible à ces employés de signaler à leur direction ce type d'activations non désirées, c'est uniquement en tant que problème technique. Il n'existe aucune procédure pour les enregistrements « sensibles » qui pourraient faire l'objet d'une enquête policière, par exemple. Les extraits audio captés par Siri sont accompagnés d'informations qui pourraient aider à identifier l'utilisateur : localisation, détails de contacts, données d'application.

Ces informations servent à déterminer si Siri a répondu correctement à la requête de l'utilisateur. Les extraits ne comprennent pas d'identifiant ni de nom spécifique ; de plus, il est très difficile de lier un enregistrement à un autre. Malgré tout, « il ne devrait pas être trop compliqué d'identifier la personne que l'on écoute », raconte l'infiltré. « Spécialement avec des déclencheurs accidentels : [on peut entendre] des adresses, des noms, etc. ».

Cette situation pourrait être encore plus dommageable si les extraits sont écoutés par de mauvaises personnes : les vérifications lors de l'embauche des personnels chargés de l'écoute sont peu fouillées « et le volume de données auxquelles nous avons librement accès est assez vaste ». Si quelqu'un chez ces sous-traitants avait des intentions néfastes, il n'aurait pas beaucoup de mal à mettre un nom derrière une voix.

Chez Amazon, il est possible de désactiver l'envoi de messages à des fins de contrôle qualité (une option qui ne sert pas à grand chose, de l'aveu même de l'entreprise). Il n'existe rien de tel chez Apple. Le livre blanc sur la sécurité du constructeur précise :

Les enregistrements vocaux de l’utilisateur sont conservés pendant six mois, afin que le système de reconnaissance vocale puisse les utiliser pour mieux comprendre la voix de l’utilisateur. Une autre copie est enregistrée après six mois, sans son identifiant, afin qu’Apple puisse l’utiliser pour améliorer et développer Siri, et ce, pendant deux ans au total. Un petit sous‐ensemble de fiches, transcriptions et données associées sans identifiant sont susceptibles de continuer à être employées par Apple pour l’amélioration continue et le contrôle de qualité de Siri au‐delà de deux ans.

Le constructeur indique au Guardian que « moins d'1% des activations quotidiennes de Siri » sont utilisées pour le service qualité, et que les extraits ne durent généralement que quelques secondes.

Qu'Apple fasse analyser des extraits audio à des sous-traitants dans le but d'améliorer la qualité de compréhension et de réponse de Siri n'a rien de choquant. Les machines n'ont pas notre oreille, après tout, et certaines situations nécessitent la compréhension d'un contexte que seul un humain peut appréhender. C'est le cas pour tous les éditeurs d'assistants connectés.

Ce qui est ici reproché finalement, c'est les cas d'activation accidentelle de Siri qui peut lancer l'enregistrement de l'extrait d'une conversation privée. Cette histoire va peut-être pousser Apple à serrer la vis et surtout à communiquer plus clairement sur ce qui passe dans les coulisses de Siri.

-

Ça ne fonctionne pas tout le temps. On peut désactiver cette fonction dans les réglages de la montre, Général > Siri > Levez pour parler. ↩