Apple adore la culture du secret qui entoure l’entreprise depuis sa création, ce qui ne veut pas dire qu’elle n’aime pas se faire mousser de temps en temps. La preuve, elle a invité un journaliste de CNET pour une visite des laboratoires normalement fermés où elle crée chaque année ses produits et en particulier son iPhone. Une visite sous haut contrôle tout de même et avec une arrière-pensée évidente : vendre les nouveaux iPhone 16. Pour les mettre au point, Apple n’a pas lésiné sur les moyens en utilisant notamment une chambre anéchoïque, un lieu conçu pour éliminer totalement les bruits extérieurs et, surtout, en éliminant tous les échos.

Grâce à cet espace, Apple a pu mesurer l’enregistrement audio de chacun des quatre microphones installés dans les iPhone 16. Le smartphone était placé au cœur d’un dispositif circulaire, où une vingtaine de haut-parleurs sont positionnés, tous dirigés vers l’appareil. Ruchir Dave, directeur senior en charge de l’ingénierie acoustique chez Apple, a expliqué qu’il s’agit d’un nouveau composant chargé d’améliorer la qualité de l’enregistrement. L’enjeu est évident : les microphones d’un téléphone sont minuscules et il faut des astuces tant matérielles que logicielles pour compenser et offrir des performances dignes d’un microphone dédié, énorme en comparaison.

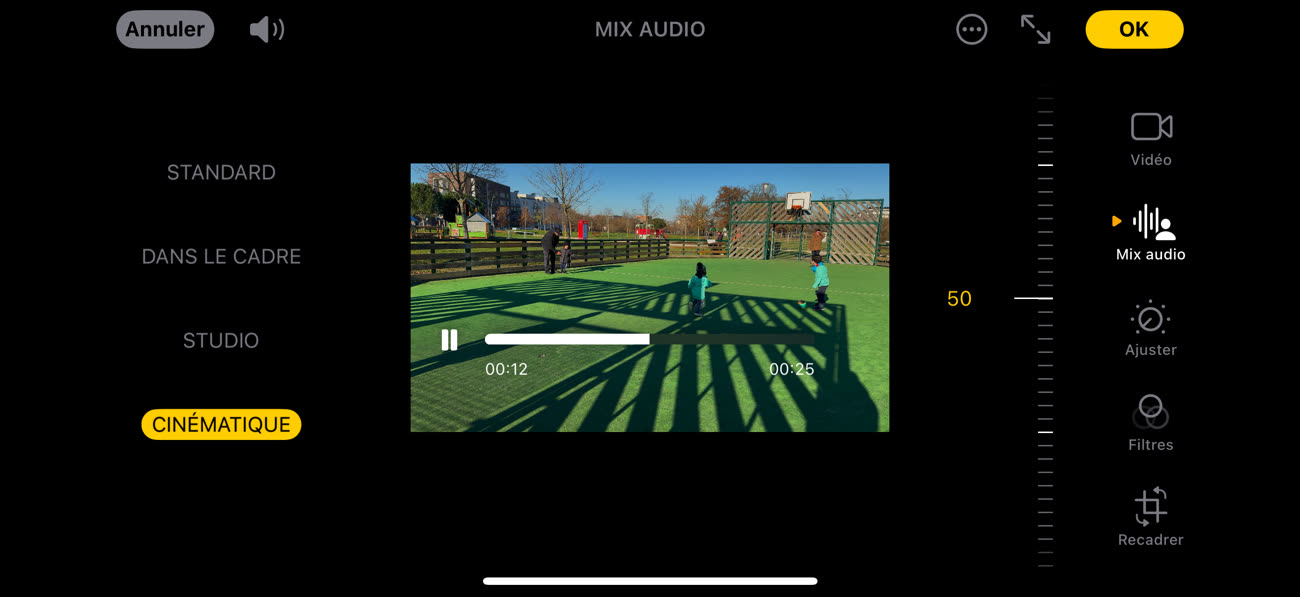

Ces enregistrements des sons générés par les haut-parleurs soigneusement positionnés par rapport à un iPhone 16 Pro dans la chambre anéchoïque a permis de créer un profil par microphone. La magie de l’apprentissage automatisé (machine learning) permet ensuite d’améliorer le résultat final en fusionnant les pistes et surtout en éliminant les bruits parasites, comme le vent. Cette approche poussée a aussi permis à Apple d’ajouter la fonctionnalité « Mix audio » qui transforme le son et crée l’illusion d’avoir filmé en studio ou en tout cas avec du matériel nettement plus complexe qu’un simple smartphone.

Pour valider les algorithmes, Apple a utilisé des humains pour une confirmation subjective de son travail. Ces tests ont été menés par des spécialistes de l’audio et aussi des utilisateurs « normaux », qui ont pu juger de la qualité de telle ou telle option. Chaque testeur est ainsi installé dans une cabine insonorisée, devant un Mac Studio associé à un Studio Display et des AirPods Max qui diffusent l’audio à évaluer. Les pistes sont proposées dans deux versions et le testeur doit choisir la meilleure et évaluer selon une grille prédéfinie les rendus. Ces résultats sont ensuite utilisés pour améliorer les algorithmes et, si tout va bien, contenter une majorité d’utilisateurs dans une majorité de situations.

Ces tests ne concernent pas que l’audio. Le journaliste de CNET a aussi vu comment Apple validait les paramètres de l’écran intégré à l’iPhone 16 pro. Cette fois, c’est une sorte de cinéma à taille réduite qui sert de lieu de test. Un écran de référence calibré professionnellement et le téléphone diffusent la même vidéo et plusieurs testeurs viennent ensuite juger si la qualité est similaire entre les deux dalles. Ces tests sont effectués dans des conditions idéales (dans le noir) et difficiles (avec une forte lumière qui simule l’extérieur), avec l’idée comme toujours de valider un maximum de scénarios réels différents. Comme l’explique un ingénieur d’Apple, il faut souvent faire des compromis pour obtenir le meilleur résultat en moyenne et ces tests permettent d’affiner les paramètres de l’écran.