Au premier coup d’œil, l’iPhone XS ressemble à l’iPhone X comme deux gouttes d’eau. Au premier coup d’œil seulement. Comme nombre de modèles « S » avant lui, il se distingue par sa fiche technique, notamment en matière d’imagerie. Montée en définition, agrandissement du capteur, perfectionnement de l’optique, stabilisation du bloc… les « années S » sont des années de progrès photographiques.

C’est encore le cas cette année : l’iPhone XS intègre un nouveau capteur et une nouvelle optique. Mais l’appareil photo n’est plus un composant isolé — il fait partie d’une chaîne de puces et de logiciels, dont les caractéristiques importent autant, si ce n’est plus, que celles du capteur. Or avec la puce Apple A12 Bionic et le Neural Engine de nouvelle génération, c’est toute la chaîne qui a été revue.

Encore aujourd’hui, l’iPhone X reste parmi les tout meilleurs « photophones » du marché. Pourtant, il fait pâle figure face à l’iPhone XS. En mariant le logiciel et le matériel, en entrant de plain-pied dans l’ère de la « photographie informatisée », Apple a franchi un cap. Explications en photos.

Un capteur plus grand

Commençons par cette photo sans grand intérêt esthétique, prise au même endroit avec les objectifs grand-angle d’un iPhone 8 Plus (à gauche) et d’un iPhone XS Max (à droite).

Le champ de vue de l’iPhone XS est plus étendu. Les données EXIF de la photo montrent qu’il possède une optique 4,25 mm, alors que l’iPhone 8 Plus possède une optique 3,99 mm. Comment une optique plus « longue » peut donner une photo plus « large » ? Avec un capteur plus grand — sauf qu’Apple, comme à son habitude, n’a pas détaillé les spécifications du capteur.

Il n’est pas difficile de les retrouver : les applications de traitement photographique donnent les distances focales équivalentes, 26 mm pour l’iPhone XS et 28 mm pour l’iPhone 8 Plus. Le grand-angle de l’iPhone XS est bien « plus grand-angle » que celui de l’iPhone 8 Plus, les choses rentrent dans l’ordre.

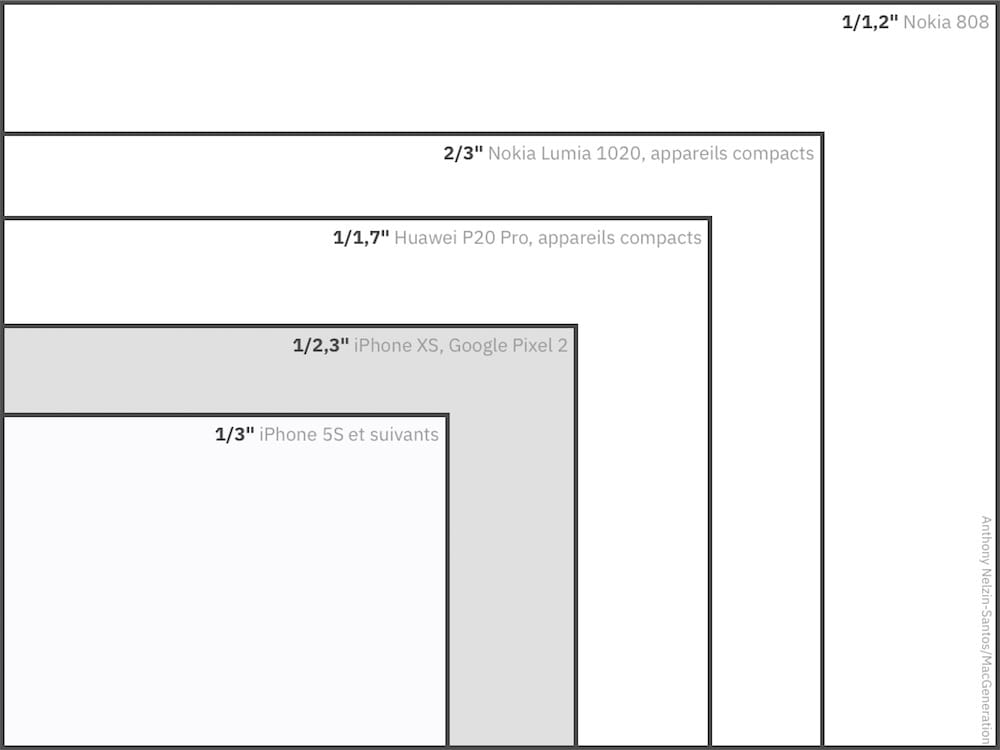

Une petite division nous donne le coefficient d’agrandissement : celui de l’iPhone 8 Plus (x7,02) correspond peu ou prou à celui d’un capteur 1/3", mais celui de l’iPhone XS (x6,12) rappelle plus le Super 8 qu’un format de capteur standard. Alors quoi ? Comme Apple parle d’un capteur 32 % plus grand et de photosites de 1,4 µm, elle utilise sans doute un capteur 1/2,3".

Le grand-angle est plus grand-angle, le téléobjectif est… moins téléobjectif. Pour conserver un « zoom x2 », il doit passer à 52 mm, contre 57 mm sur l’iPhone 8 Plus. C’est bien le seul changement apporté à cette partie de l’appareil photo. Le téléobjectif reste comparativement moins lumineux que le grand-angle (ƒ/2,4 contre ƒ/1,8) et reste associé à un petit capteur 1/3,6" d’ancienne génération.

L’iPhone XR montre que ce deuxième capteur n’est pas absolument nécessaire, d’autant moins qu’il est régulièrement désactivé. On ne regrettera pas sa présence : il apporte des informations supplémentaires, améliore la qualité du zoom numérique, participe au mode Portrait. Mais il est difficile de continuer à s’enthousiasmer, quand on voit ce que Google sait faire avec un seul capteur, ou ce que d’autres font avec un deuxième capteur monochrome ou une deuxième optique très-grand-angle.

Des couleurs plus saturées

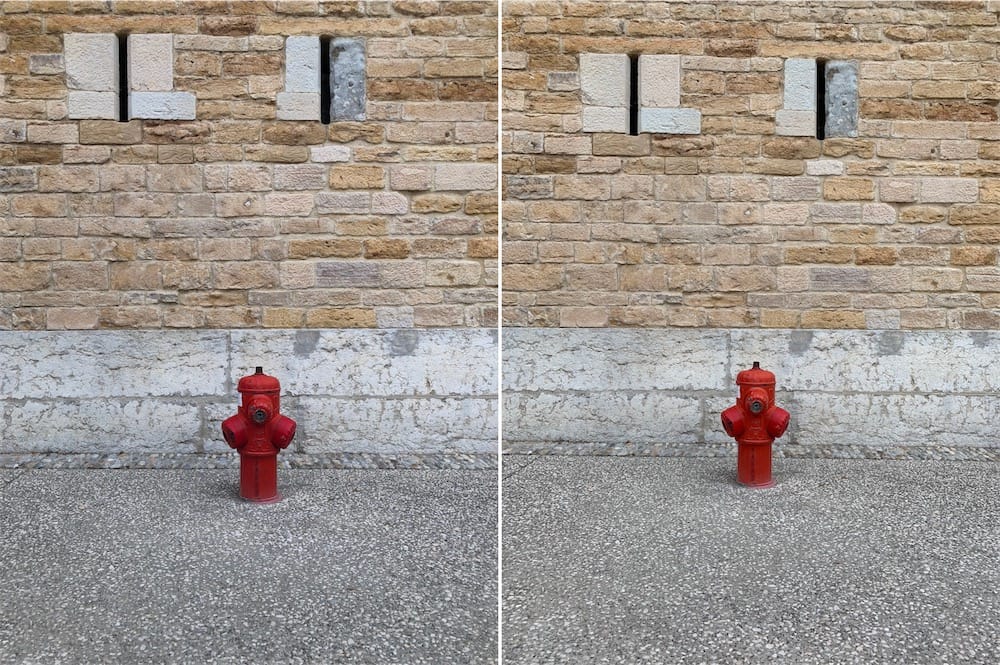

Ces deux premières photos vous ont peut-être mis la puce à l’oreille : l’iPhone XS accélère la tendance des dernières années en matière de réchauffement colorimétrique. Apple a rejoint le camp de Samsung, et privilégie un traitement flatteur des couleurs, alors que Google s’en tient à une interprétation plus neutre. Cette tendance touche tout le spectre, comme le montrent les photos suivantes.

Faut-il s’en plaindre ? Difficile de le dire : dans les précédents exemples, l’iPhone XS nous semble mieux retranscrire la profondeur de la verdure et la chaleur des briques, mais l’iPhone 8 capte mieux le ciel orageux. Cette comparaison directe accentue la différence de traitement — au quotidien, elle n’est pas toujours aussi tranchée.

Apple n’a pas fait ce choix au hasard : sur l’écran OLED de l’iPhone XS, qui prend en charge l’espace colorimétrique étendu P3, les photos sont vibrantes et lumineuses. Plus qu’une question technique, il s’agira d’une question de goût. Certains trouveront ce traitement flatteur et naturel, d’autres le trouveront complaisant et artificiel.

Un dynamique Smart HDR

Regardez le ciel de la première photo de cet article, ou le coin gauche de la précédente. Alors que les tons les plus clairs ne sont pas loin d’être « cramés » sur les anciens iPhone, ils restent colorés sur l’iPhone XS. Grâce à des photosites plus « profonds », capables de capter jusqu’à 50 % de lumière en plus, et une électronique améliorée, le nouveau capteur possède une meilleure dynamique1.

L’iPhone XS ne captera pas le souvenir du bleu dans un ciel laiteux et se laissera éblouir par un spot de chantier, mais sera capable de capter les détails d’une enseigne lumineuse ou de révéler les secrets d’un couloir obscur. Là où les iPhone 8 et X ratent la photo s’ils ne passent pas en mode HDR, et parfois même s’ils passent en mode HDR, l’iPhone XS prend une photo « normale ».

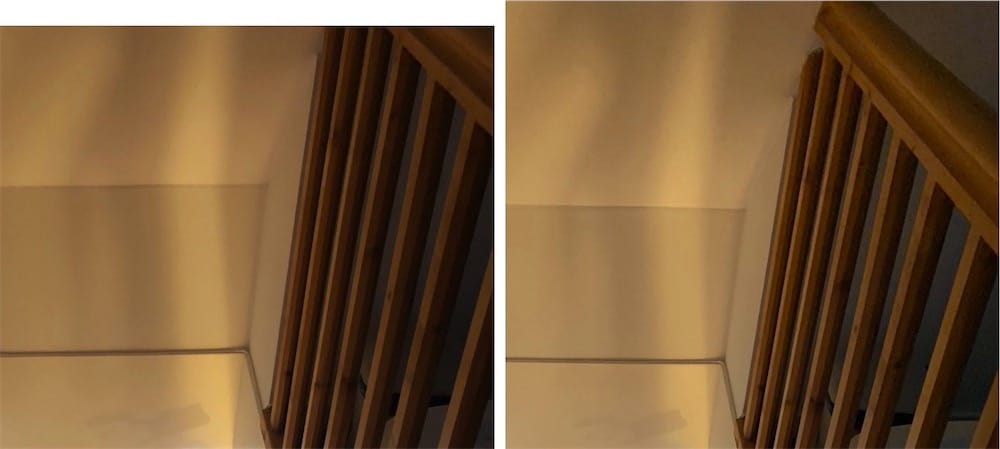

Les guillemets sont de rigueur : les seules capacités du capteur ne parviennent pas à expliquer certaines différences à peine croyables. Grâce au processeur A12 et au Neural Engine, Apple peut jouer avec le flux de données provenant du capteur pour composer et recomposer des images. À chaque fois que vous appuyez sur le déclencheur, l’iPhone XS prend jusqu’à neuf photos successives, et réalise des milliards d’opérations pour assurer le meilleur résultat.

Le téléphone est autant photographe que vous, vous ne maîtrisez pas l’ensemble des paramètres, le logiciel et le matériel font des choix à votre place. Comme celui de décider que telle photo mérite le label « HDR », et pas une autre, alors qu’elles sont toutes produites par fusion de multiples expositions.

Vous voulez seulement prendre une photo au débotté ? Ces automatismes vous sauveront la mise. Vous voulez prendre le temps de composer une photo ? Ces automatismes vous mettront des bâtons dans les roues. Le logiciel veut corriger toutes les erreurs, mêmes quand elles sont intentionnelles. Ainsi, il est beaucoup plus difficile de réaliser des silhouettes, puisque le Smart HDR veut éviter de boucher les ombres, ou de « noyer » un sujet en contre-jour, puisqu’il veut éviter de cramer les hautes lumières.

Et puis tout « Smart » soit-il, le mode HDR n’est pas toujours pertinent. L’iPhone XS décide parfois de pousser les traitements dans des situations qui ne devraient pas poser de problème particulier, ce qui n’est pas particulièrement grave, mais aplatit quelque peu les photos, en compressant la dynamique. Surtout, il fait parfois plus de mal que de bien, comme dans l’exemple suivant, certes plutôt rare.

Des portraits

Pour être tout à fait complet, il faut enfin parler du mode Portrait, qui repose désormais sur une notion d’ouverture virtuelle. Dans la plupart des cas, Apple simule le flou de profondeur d’un objectif ouvrant à ƒ/4,5 (devant un capteur APS-C ? Un capteur plein format ? Allez savoir !). Après coup, ce flou peut être renforcé pour correspondre à celui d’un caillou ouvrant à ƒ/1,4, ou diminué comme si l’on fermait à ƒ/16.

Bien sûr que cette fonction tient du gadget. Mais vous savez quoi ? Un gadget peut en dire long. La simulation de l’ouverture montre les progrès constants du mode Portrait. S’il trébuche toujours sur les mèches volantes ou les branches de lunettes, il n’est plus effrayé par les boucles et les bijoux. Surtout, en faisant varier le curseur d’ouverture virtuelle, on voit comment le flou est appliqué non pas seulement à l’arrière-plan, mais aussi à l’avant-plan.

Le visage n’est plus découpé à l’emporte-pièce sur le fond, mais graduellement flouté. À ƒ/1,4, quelques centimètres seulement sont nets, comme ils le seraient si l’on avait pris la photo avec un boîtier professionnel. C’est encore un flou trop parfait, sans les imperfections et les bokeh balls qui font le charme de certains cailloux d’exception, mais cela commence à devenir franchement impressionnant.

Et cela veut dire qu’à travers le logiciel, une optique physique ƒ/1,8 devient une optique logicielle ƒ/1,4. On ne parle bien sûr que des caractéristiques du flou de profondeur — aucun logiciel ne fera rentrer plus de lumière dans le boîtier. Mais cette fonction contribue à nous faire entrer dans un monde où l’on ne voit plus où s’arrête le logiciel et où commence le matériel. La photographie numérique sera — elle l’est encore à peine — le véritable produit de la vision du capteur, du traitement du processeur, de l’interprétation des algorithmes.

Comme Apple, Google mise à fond sur le traitement logiciel réalisé en local sur ses Pixel. Et si les fabricants traditionnels semblent faire du surplace depuis des années, c’est que leurs processeurs sont cruellement moins rapides que les puces conçues à Cupertino. Google produit parmi les tout meilleurs photophones, les boîtiers reflex ont encore de beaux jours devant eux : l’approche d’Apple n’est pas nécessairement meilleure, mais elle continue à distinguer clairement l’iPhone des autres appareils photo.

- Autres différences, toujours sur le « grand » capteur de l'objectif grand-angle : la durée maximale d'exposition passe à une seconde (contre 1/3 s auparavant) et la sensibilité maximale grimpe à ISO 2304 (contre ISO 2112). ↩︎