Apple Intelligence a un problème avec les genres. La journaliste du Wall Street Journal Joanna Stern en a fait l’expérience : l’IA n’arrête pas de synthétiser des messages évoquant son mari… alors qu’elle est mariée avec une femme. Un couac de la fonction « Résumer les notifications » qui est loin d’être le premier.

I love my hallucinated husband. Yes, Apple Intelligence keeps insisting I have one when summarizing my wife’s messages. Apple says it’s working on a fix and designed its AI to avoid reinforcing stereotypes and biases. More in my newsletter: techthings.cmail20.com/t/d-e-sjrttn...

— Joanna Stern (@joannastern.bsky.social) 17 janvier 2025 à 18:59

[image or embed]

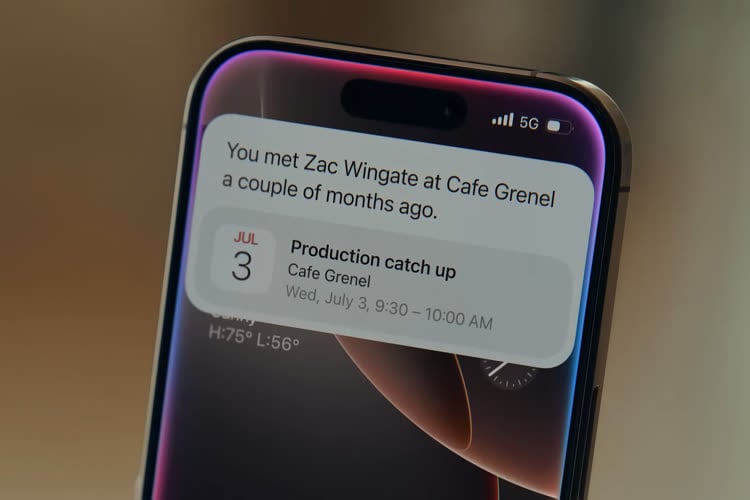

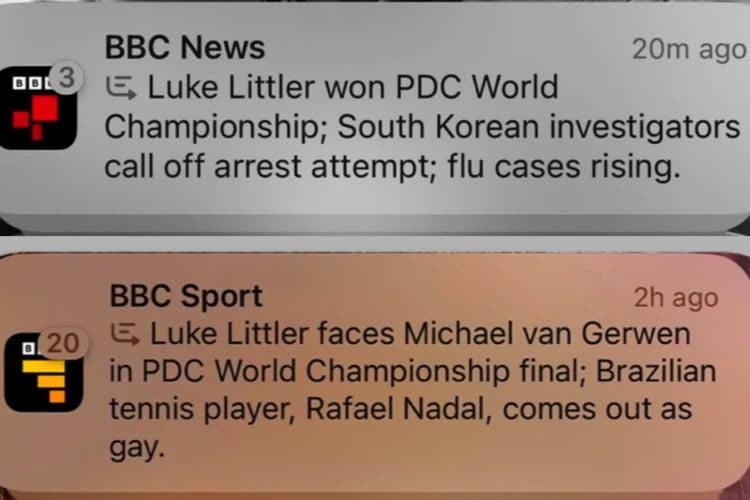

Apple s’est déjà fait taper sur les doigts par différents médias après avoir mal reformulé leurs notifications : plutôt que de faire gagner du temps, le résumé donnait une fausse information. Cupertino a fini par débrancher cette fonctions pour les apps d’actualité, mais on sait qu’elle a du mal avec d’autres types de contenus. The Verge avait compilé plusieurs reformulations bizarres et effrayantes, annonçant par exemple des tentatives de suicide de proche ou mélangeant deux messages pour donner de fausses bonnes surprises.

Apple Intelligence continue de créer de fausses informations en reformulant les notifications de la BBC

Johanna Stern explique que ce « mari » imaginaire apparaît souvent pour les résumés de messages dans lesquels sa compagne évoque leur fils. Elle pense que la confusion vient du fait que sa femme est nommée « Épouse » dans ses contacts, ce qui ferait halluciner le modèle sur certains messages ne contenant que des pronoms masculins comme « il » ou « lui ».

Ma femme m'a envoyé un message à propos de la chambre en désordre de notre fils de 7 ans. Le résumé de l'intelligence d'Apple se lit comme suit : « Exprime sa frustration face au désordre et au manque de bon sens de son mari ».

Les IA génératives reposent sur un principe de déduction et n’ont pas de connaissance à proprement parler : elles se contentent de prédire le mot le plus probable selon le contexte et le style. La fonction a sans doute ce biais après avoir été formée sur des textes dans lesquelles les relations homosexuelles sont moins représentées que les autres. Apple a déclaré que ses outils ont été conçus selon des principes responsables et « afin d'éviter de perpétuer les stéréotypes et les préjugés systémiques ». Elle invite les personnes aux résumés erronés à signaler le souci, et affirme que la précision de l’IA s’améliorera au fil du temps.