Apple semble avoir remisé au fond d'un placard sa fonction de détection d'images pédopornographiques dans la bibliothèque Photos d'iOS et iPadOS. Dans la page qui détaille les nouvelles mesures de protection des jeunes utilisateurs, cette fonction en particulier — une des trois annoncées au cours de l'été — a complètement disparu du descriptif.

Précédemment, la page indiquait que cette fonction d'analyse des images avant leur envoi dans la photothèque d'iCloud faisait l'objet d'un développement plus approfondi avant son lancement (aux États-Unis d'abord). Il s'agissait pour Apple de se donner du temps au vu des nombreuses critiques essuyées par son initiative.

Apple repousse ses mesures controversées de lutte contre la pédopornographie

Depuis la sortie d'iOS 15.2 cette page a été remaniée et expurgée de toute référence à cette fonction, même à une date indéterminée. Une modification qui a l'allure d'un enterrement pur et simple.

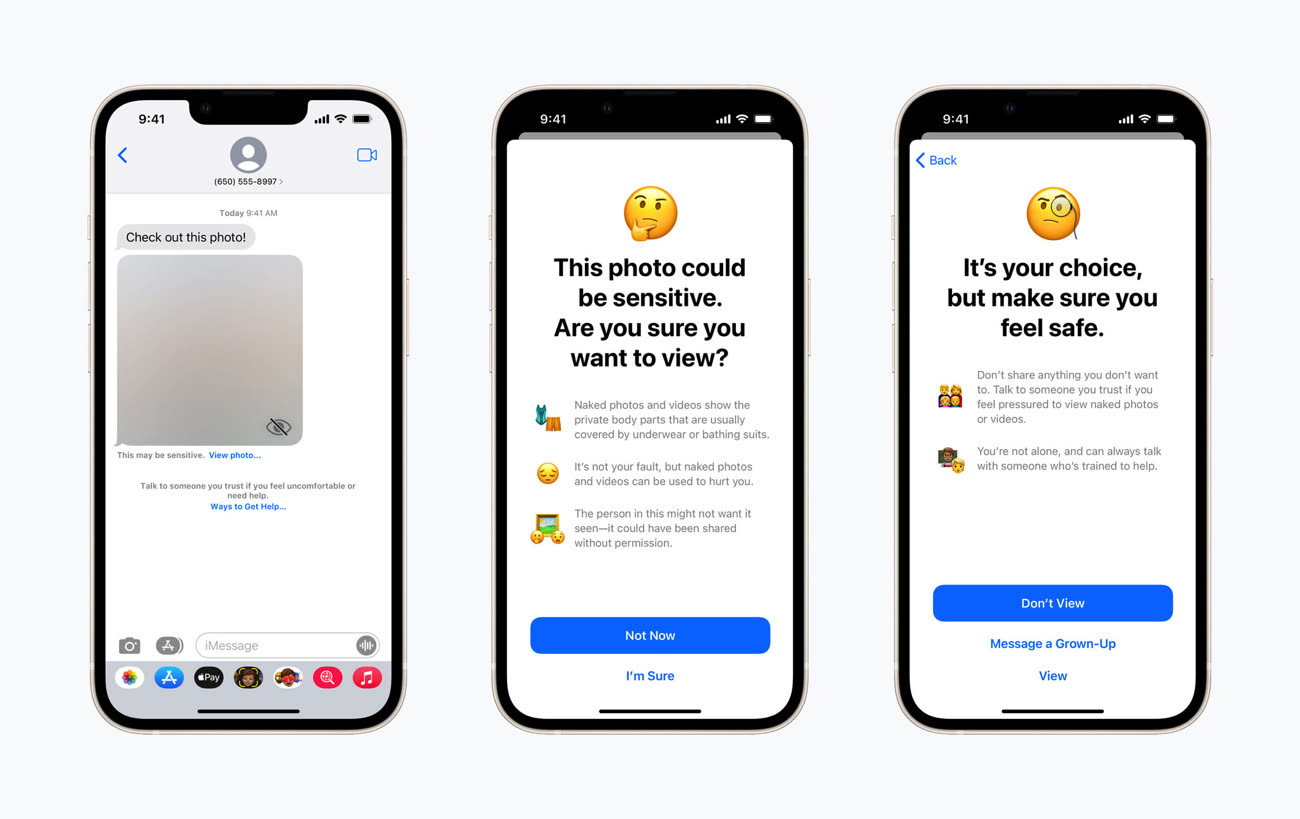

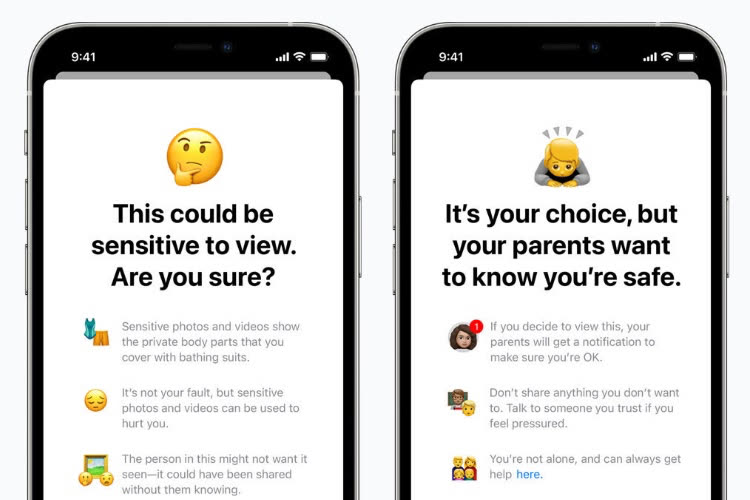

Apple a conservé deux fonctions qui sont inaugurées auprès du public américain : d'abord le floutage d'images de sujets supposément nus dans les échanges au sein de Messages, ensuite des ressources fournies par Siri, Spotlight et la recheche de Safari sur l'exploitation sexuelle de mineurs. Le planning pour un déploiement à l'internationnal reste inconnu.

Protection de l'enfance : la fonction de floutage des photos sexuellement explicites dans Messages apparait dans iOS 15.2 🆕

Mise à jour 18h — Apple a peut-être retiré les références à la détection des photos pédopornographiques dans le descriptif de son site consacré aux mesures de protection contre l'enfance, le constructeur n'a pas du tout enterré sa technologie. Il s'agit toujours d'un report, pas d'un abandon, a affirmé une porte-parole à la presse US. Comme Apple l'avait expliqué en septembre, il s'agit de prendre son temps pour prendre en compte les retours des spécialistes, des chercheurs et des groupes de défense de la vie privée.

Source :