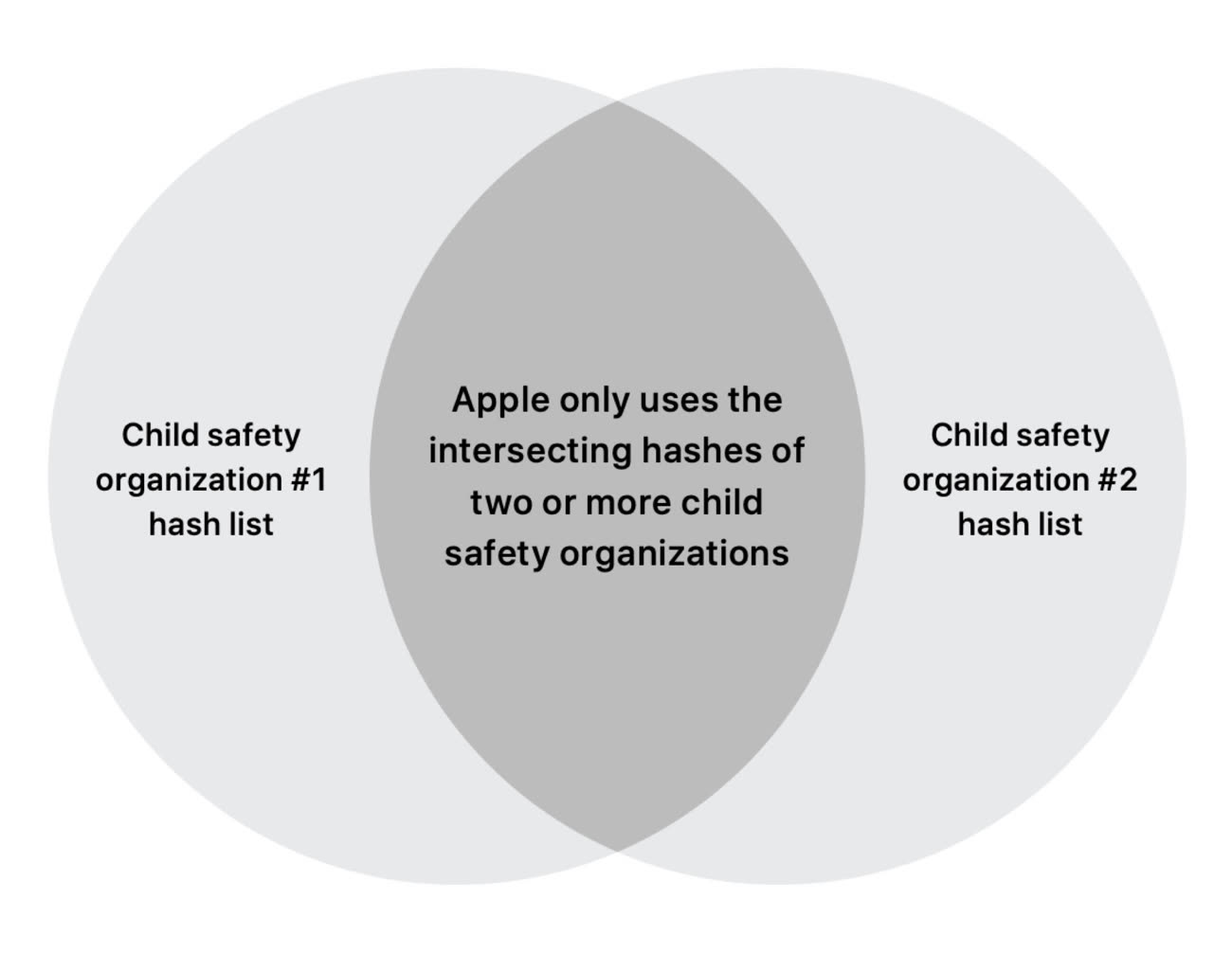

Un développeur est parvenu à « ouvrir » l'algorithme NeuralHash, la technologie qui permet à Apple de comparer en local les images contenues dans la bibliothèque photos de l'iPhone avec celles d'une base de données d'images pédopornographiques. En l'occurrence, on ne parle pas de comparaisons directes entre les photos, mais de comparaisons entre des suites de chiffres (hash).

Asuhariet Ygvar a publié sur GitHub une version Python de NeuralHash, créée à grands renforts d'ingénierie inverse depuis d'anciennes versions d'iOS. Ce n'est pas à proprement parler l'algorithme spécifique développé par Apple, mais une mouture générique qui permet quand même de se faire une petite idée de son fonctionnement.

La mise en ligne de ce code a permis à plusieurs amateurs de bidouiller l'algo ; un d'entre eux explique avoir trouvé un procédé permettant de duper le réseau neuronal sur lequel Apple s'appuie pour réaliser le comparatif. Il semble donc que le système d'Apple puisse prendre des vessies pour des lanternes : une image sans rapport avec la pédopornographie pourrait donc apparaitre comme suspecte en portant le même numéro qu'une image signalée comme pédopornographique (« collision de hashes »).

Apple a néanmoins tenu à rassurer. Le constructeur a indiqué que la version analysée par les développeurs était générique, ce n'est pas la version finale qui sera livrée cet automne aux utilisateurs américains.

Le système de détection de photos pédophiles a pris en compte ce genre de cas : si une image génère un signalement NeuralHash, elle sera de nouveau vérifiée par un deuxième système dont les spécifications ne sont pas publiques. Ce dernier pourra donc identifier que la correspondance est une erreur, avant qu'elle soit transmise aux vérificateurs humains. Il faudra donc faire confiance à Apple sur ce coup là.

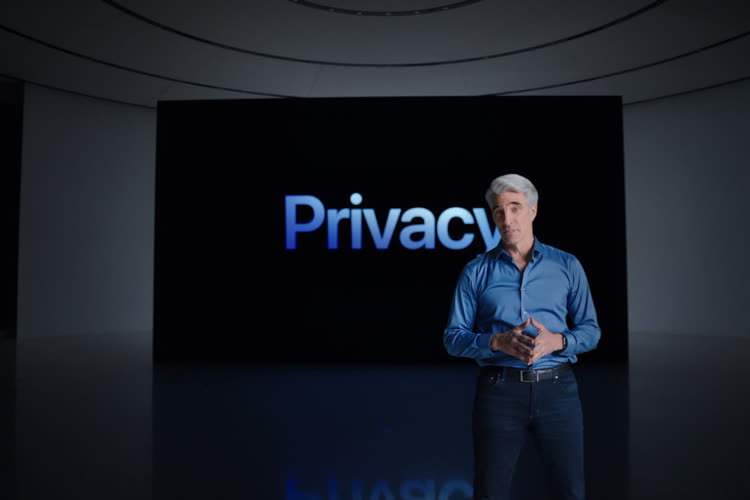

Par ailleurs, Craig Federighi a précisé il y a quelques jours qu'un minimum de 30 images correspondantes à celles de la base de données doivent être remontées par le système avant qu'une alerte rouge soit lancée chez Apple. Et ensuite, il y a encore une étape d'examen par des employés.

Craig Federighi reconnait qu'Apple a très mal communiqué sur les mesures de lutte contre la pédopornographie