La « correction de l'attention » avec FaceTime dans iOS 13 est la fonction qui a le plus surpris après sa découverte dans la bêta 3. Elle n'avait pas été mentionnée lors du keynote de la WWDC et ne figure pas dans la liste des principales nouveautés à attendre à la rentrée.

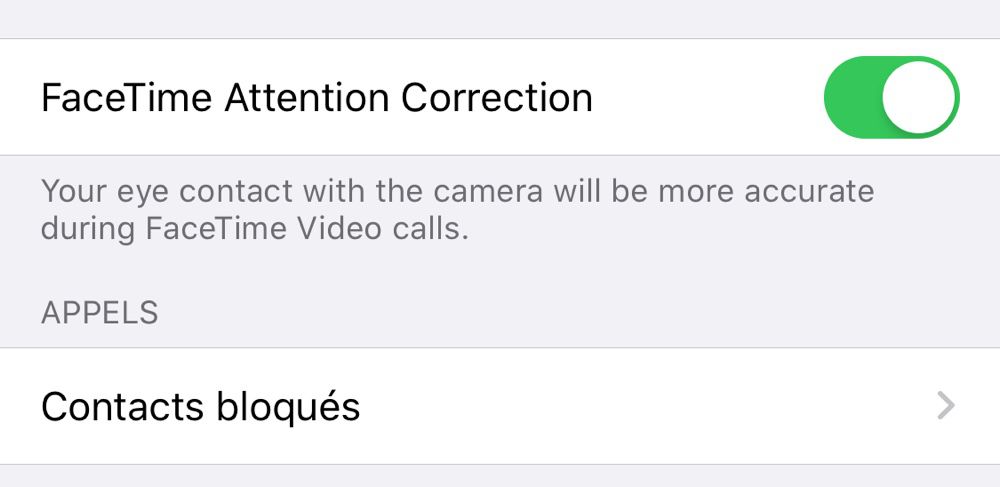

Après l'avoir essayée depuis hier, à de multiples reprises, sur les appareils où cette fonction apparaît — iPhone XS, XS Max et iPad Pro 2018 — elle nous a laissé sur notre faim. L'effet, qui semble impeccable dans les quelques captures qui ont circulé, n'est pas toujours aussi évident à constater. Déjà sur nos iPad Pro, la fonction — qui se présente comme une option dans les réglages de FaceTime — n'a pas l'air de faire quoi que ce soit.

Sur iPhone, les résultats sont variables, on aurait aimé pouvoir dire que, oui, ça fonctionne « drôlement bien ». Will Simon, qui a le premier, découvert cette option, a publié deux captures convaincantes. À gauche, il plante son regard dans la caméra frontale de son iPhone. Il peut donner l'impression de regarder son interlocuteur mais ses yeux sont légèrement orientés vers le haut. À droite, il vise l'écran et alors que son regard devrait être beaucoup plus orienté vers le bas, il donne l'illusion de faire face à son contact. FaceTime a appliqué une correction au niveau des yeux pour en modifier l'angle.

Il est toutefois assez difficile d'obtenir un aussi bon résultat. Après bien des essais on arrivait le plus souvent à ce genre de situation dans les captures suivantes. Dans la première rangée, Cédric regarde la caméra de son iPhone, son regard va presque dans ma direction mais il est légèrement relevé. C'est plus confortable pour moi, puisque j'ai l'impression qu'il me fixe, ça l'est moins pour lui, vu qu'il voit surtout sa caméra.

Dans cette rangée, Cédric regarde cette fois le milieu de son écran, comme on est supposé le faire pendant une discussion. La correction nous a paru moins flagrante et efficace que sur l'exemple de Will Simon. Au moins le regard ne pointe pas complètement vers le bas, on est dans un entre-deux et on espérait bien mieux.

Plus bas, une vidéo de MacRumors illustre aussi cette fonction, on s'en fera soi-même une opinion. Quoi qu'il en soit, l'idée est futée. Apple n'ayant jamais parlé de cette fonction, la manière dont elle opère n'est pas expliquée.

Dave Schukin, cofondateur d'une société qui fabrique un dispositif de suivi du regard pour les automobilistes, suggère qu'Apple utilise ARKit pour appliquer un ajustement ou une déformation au niveau des yeux par rapport au visage, en temps réel.

Il en veut pour preuve qu'en faisant passer un objet entre son visage et le capteur TrueDepth, il est brièvement déformé lorsqu'il arrive pile devant les yeux, comme on le voit dans sa vidéo avec une branche de lunettes et ci-dessus avec une baguette.

How iOS 13 FaceTime Attention Correction works: it simply uses ARKit to grab a depth map/position of your face, and adjusts the eyes accordingly.

— Dave Schukin 🤘 (@schukin) 3 juillet 2019

Notice the warping of the line across both the eyes and nose. pic.twitter.com/U7PMa4oNGN

La fonction n'ayant pas été officiellement annoncée, rien ne dit qu'elle restera en place jusqu'à la première version finale d'iOS 13. Elle peut aussi disparaître et revenir dans une mise à jour intermédiaire. FaceTime a encore des bugs avec cette bêta 3, la surimpression d'un Animoji sur un visage fonctionne très mal par exemple.