Apple martèle à longueur d’années qu’elle fait tout pour préserver la vie privée de ses utilisateurs, mais même Apple fait écouter une partie des requêtes de Siri par des humains pour améliorer son assistant vocal. L’information est apparue après des polémiques similaires concernant Alexa d’Amazon et l’Assistant de Google, mais Siri n’est pas différent finalement, comme on l’a appris en fin de semaine dernière :

Les trois entreprises ont beau expliquer que c’est nécessaire pour améliorer le service, que seule une petite portion des requêtes sont traitées ou encore que l’anonymat des utilisateurs est respectée, c’est un comportement qui peut poser problème. Heureusement, il y a en général des options pour l’éviter, même si elles ne sont pas mises en avant. Pour Siri, il y a bien un moyen, mais il n’est clairement pas pensé pour être mis en place facilement.

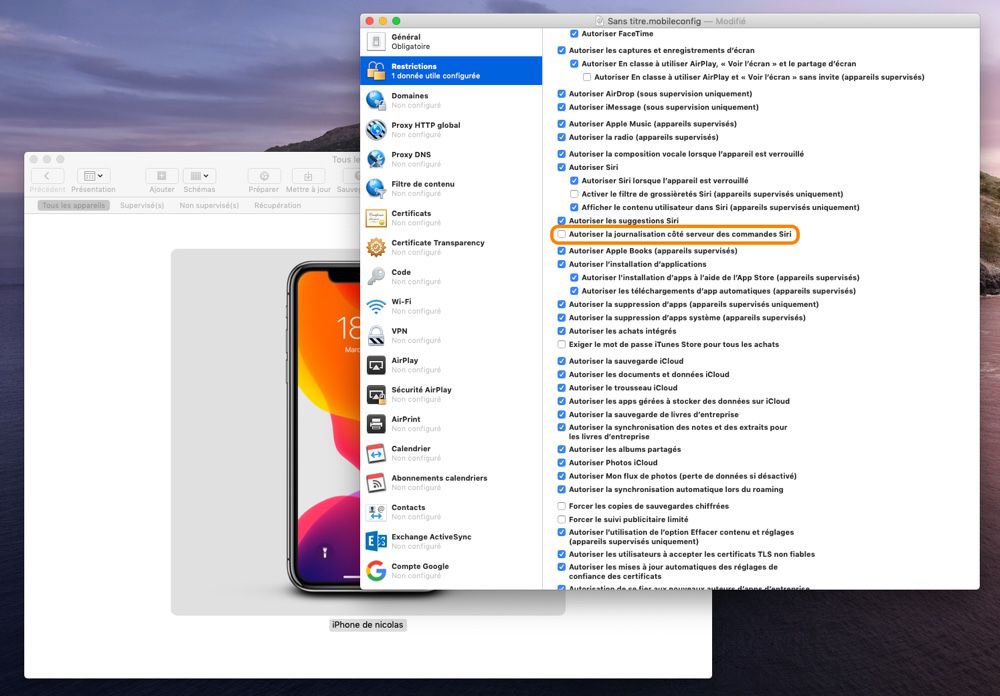

Pour que Siri cesse d’envoyer une partie de vos requêtes sur des serveurs où elles pourraient être sélectionnées pour une analyse humaine, vous devez créer un profil de configuration en utilisant l’app Apple Configurator. Décochez la case « Autoriser la journalisation côté serveur des commandes Siri » dans la section dédiées aux restrictions, puis installez ce profil sur tous vos appareils et vous serez tranquille.

Cette solution nécessite d’avoir un Mac sous la main, ce qui n’est évidemment pas le cas de tous les utilisateurs d’iPhone et iPad. C’est pourquoi un chercheur en sécurité propose sur GitHub un profil prêt à emploi que vous pouvez installer directement sur votre appareil iOS. Comme c’est sur GitHub, le code source est accessible publiquement et permet de vérifier que le profil ne fait qu’une chose, désactiver l’enregistrement sur les serveurs d’Apple des requêtes Siri.

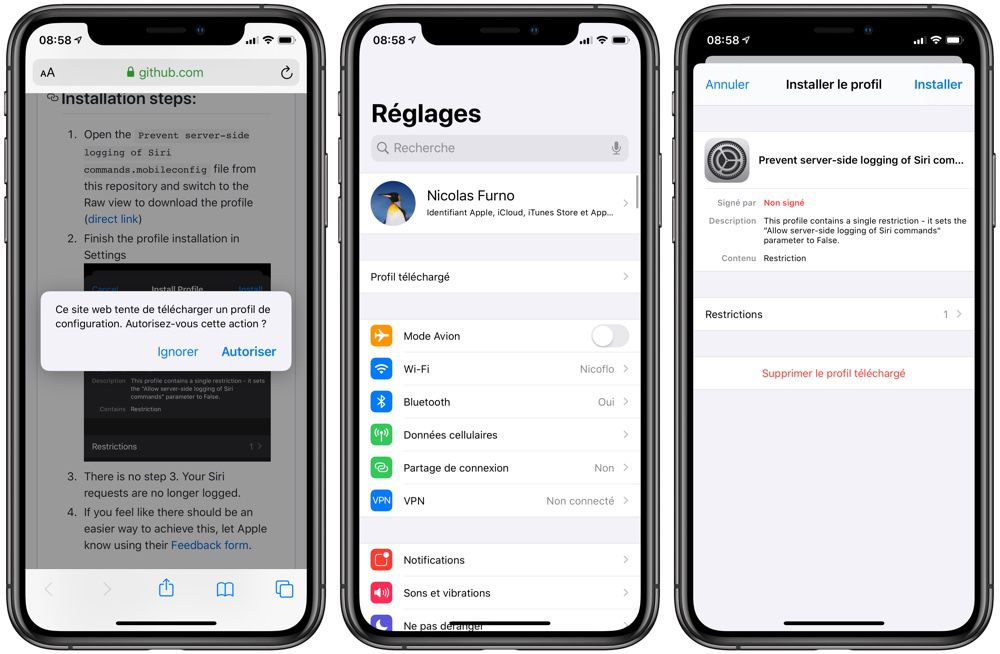

Pour l’installer, vous devez ouvrir le lien direct vers le profil depuis un appareil iOS et autoriser son installation. Ouvrez ensuite l’app Réglages, vous devriez voir une ligne « Profil téléchargé » en haut de l’écran. Dans cette catégorie, vous verrez le profil téléchargé à l’étape précédente et vous pourrez l’installer. Comme il n’est pas signé, iOS demande une confirmation supplémentaire, mais il n’y a pas de risque à l’installer.

Une fois que c’est fait, vous ne noterez aucun changement sur votre appareil, Siri fonctionnera comme avant. Mais ce que vous demandez à l’assistant vocal d’Apple ne sera plus stocké sur des serveurs et potentiellement écouté par des humains. Espérons que le constructeur ajoute une case dans les réglages de Siri pour éviter de passer par un profil, comme le font déjà ses concurrents.

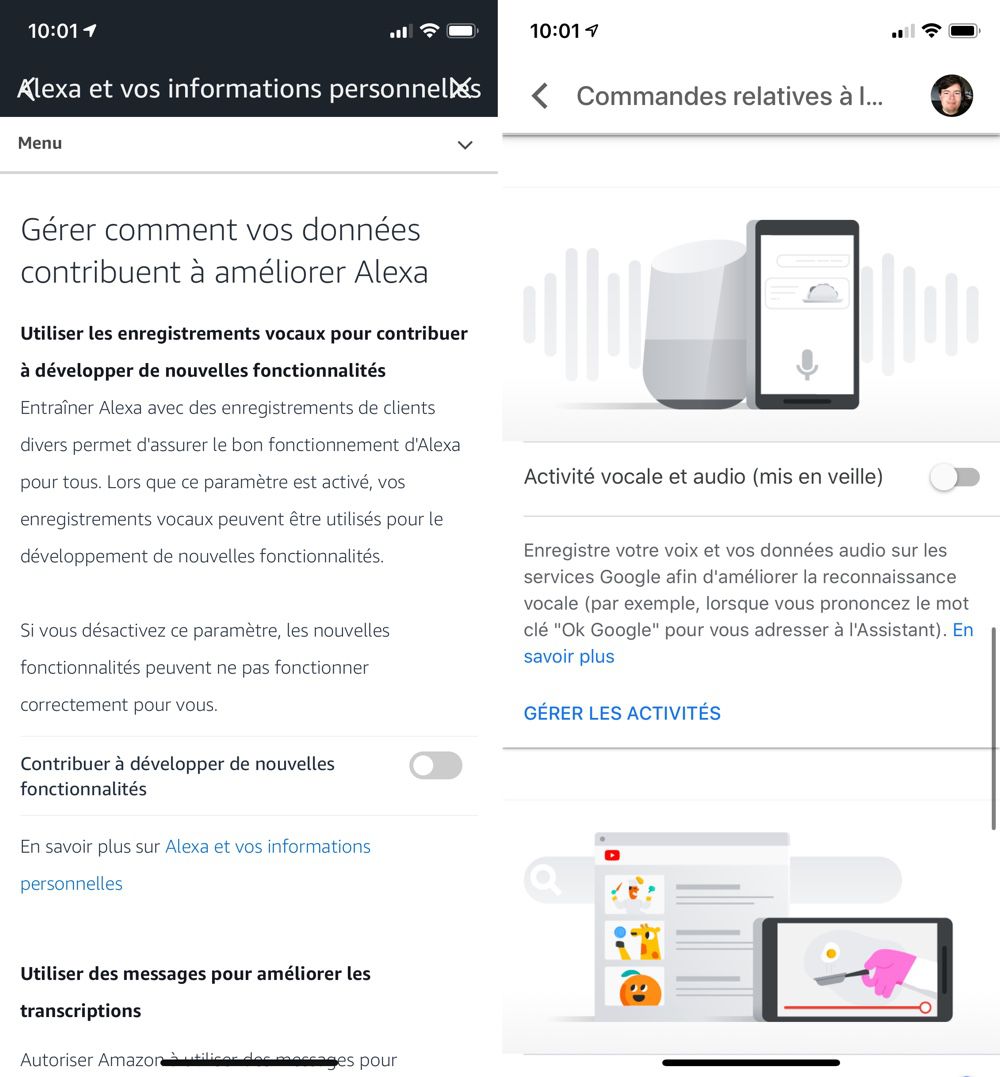

Pour désactiver le traitement humain des commandes vocales Alexa, ouvrez l’app d’Amazon, puis dans les paramètres, ouvrez la section « Alexa et vos informations personnelles » et enfin « Gérer comment vos données contribuent à améliorer Alexa ». Décochez les deux cases pour que vos enregistrements audio ne soient pas traités.

Pour faire la même chose avec Google Assistant, ouvrez l’app et touchez votre avatar en haut à droite de l’écran pour accéder aux paramètres. Sélectionnez ensuite le bouton « Gérez votre compte Google », puis « Infos perso et confidentialité », faites défiler pour trouver « Commandes relatives à l’activité » et décochez le paramètre « Activité vocale et audio ». Dans les deux cas, vous trouverez aussi un historique des commandes enregistrées avec des options pour faire le ménage.

[MàJ 30/07/2019 10h50] : point important à ne pas oublier, l’astuce évoquée ici ne concerne que les appareils iOS et tvOS. L’Apple Watch et le HomePod ont aussi accès à Siri et, sauf erreur de notre part, il n’est pas du tout possible de désactiver le stockage des requêtes sur les serveurs d’Apple.

Source :