Parmi toutes les nouveautés présentées par Apple cette semaine, il en est trois destinées aux développeurs qui sortent particulièrement du lot : la réalité virtuelle avec des Mac puissants capables de développer des expériences VR, la réalité augmentée avec ARKit qui donne déjà des résultats épatants, et l’intelligence artificielle.

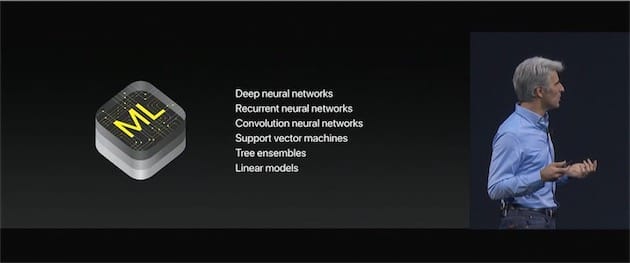

Core ML est un framework qu’Apple exploite dans bon nombre de ses services et applications (Siri, Appareil photo, le clavier QuickType…). Le constructeur l’ouvre maintenant aux développeurs tiers afin qu’ils mettent au point des applications plus intelligentes, et les premiers résultats sont plutôt encourageants même s’il reste du travail, bien sûr. L’apprentissage automatique est un concept qui parait un peu lointain, mais les outils mis à disposition par la Pomme le rendent plus abordable.

Mais il faut garder à l’esprit que Core ML n’est rien s’il ne s’appuie pas sur des modèles d’apprentissage automatique, comme des réseaux neuronaux, des modèles linéaires, des arbres de décision… Pour faire simple, ces modèles permettent à l’application intégrant Core ML de reconnaitre des objets en tout genre : animaux, paysages, arbres, véhicules, babioles, personnes… Apple oblige, tout est calculé dans l’iPhone ou l’iPad, rien n’est envoyé sur les serveurs mais il convient de « nourrir » Core ML. C’est pourquoi le constructeur propose de télécharger des modèles open source, ce qui permet de tester rapidement les capacités de la technologie.

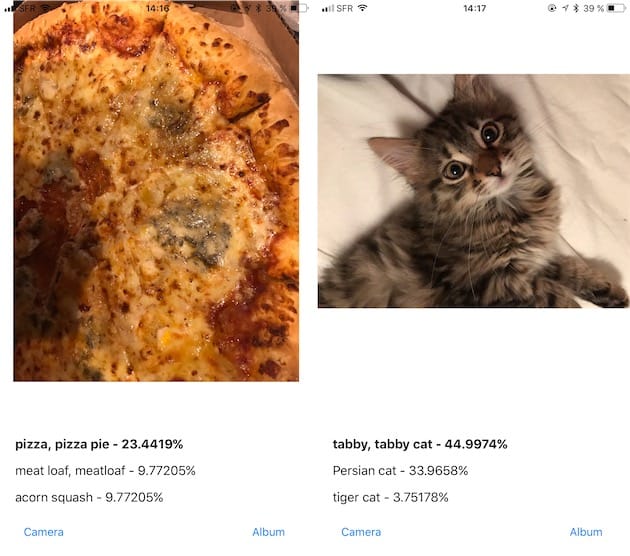

Mais tout cela, c’est du blabla. Pour se rendre compte du potentiel de Core ML, nous avons tout simplement compilé deux applications embarquant des modèles conseillés par Apple. La première, simplement baptisée ML (Github), utilise le modèle ReNet50 qui reconnait des objets dans mille catégories. Le principal atout de cette app, c’est qu’elle affiche le nom de l’objet en direct : la reconnaissance est immédiate, mais les résultats sont souvent fantaisistes. Exemple en vidéo :

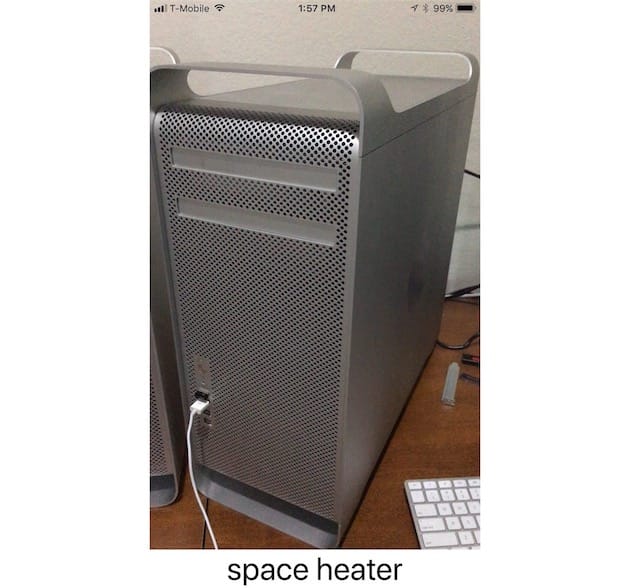

Paul Haddad, le développeur de Tapbots, a utilisé le modèle VGG16 avec plus de succès :

I wasn’t joking either just got to get it at the right angle. This also really heats up this phone. pic.twitter.com/dvOEXdHHTn

— Paul Haddad (@tapbot_paul) 8 juin 2017

Certains résultats sont assez amusants, comme ce Mac Pro “alu” pris pour… un chauffage. Après tout, ce n’est pas complètement faux !

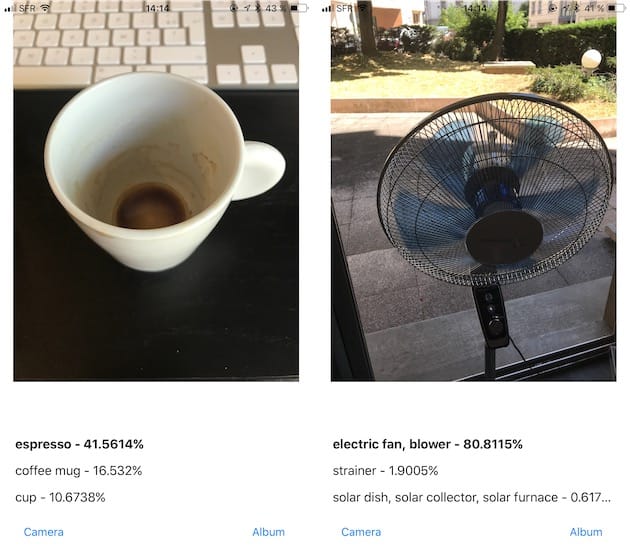

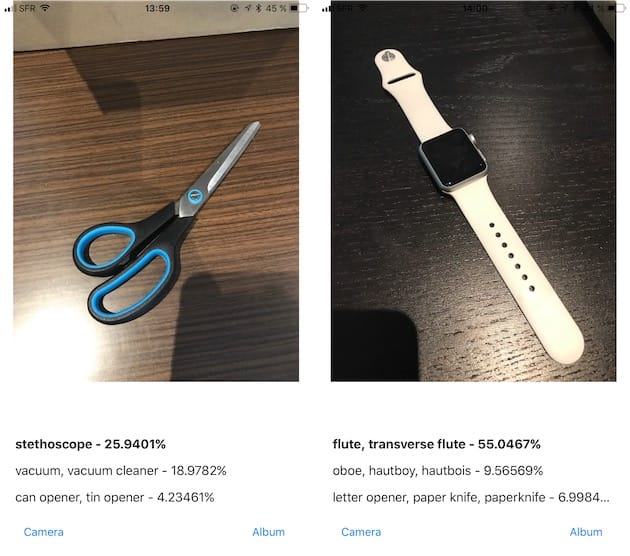

L’autre application testée, CoreML Vision (Github), offre un taux de déchet plus faible, mais les résultats sont moins rapides à obtenir. Il faut en effet prendre une photo puis patienter quelques secondes avant d’obtenir un résultat, mais celui-ci tape juste assez souvent… et parfois avec une précision diabolique ! Nous avons installé le modèle Inception V3, qui là aussi détecte des objets de mille catégories.

Le pourcentage donné par l’application correspond à la probabilité que l’objet reconnu soit celui pris en photo. Les résultats ne sont pas infaillibles évidemment, comme le montrent les deux exemples ci-dessous :

Si personne n’a appris au modèle à reconnaitre une paire de ciseaux ou une montre connectée, ces résultats ne sont pas étonnants. La qualité de la prise de vue peut aussi jouer.

Analyser et identifier des objets, c’est une première étape essentielle évidemment, mais il faut imaginer les utilisations qui en découleront. Il revient à Apple — qui en fait déjà usage — et surtout aux développeurs tiers d’imaginer les possibilités qui s’ouvrent grâce à Core ML.