Une petite équipe d'Apple et de l'Université de Carnegie Mellon au États-Unis a publié ses travaux sur un système baptisé "Listen Learner". Il vise à rendre les assistants électroniques capables de comprendre la nature des sons qui les entourent et d'exécuter des actions en conséquence.

Il y a deux ans, avant de rejoindre Apple, l'un de ces chercheurs, Gierad Laput, avait travaillé sur ce mécanisme et proposé quelques exemples pratiques. Dans un atelier, le téléphone de l'opérateur pourrait afficher une consigne de sécurité — comme d'enjoindre de mettre ses lunettes de sécurité — lorsqu'il reconnaît le bruit d'une machine-outil qui est mise en marche.

Dans la cuisine, l'assistant pourrait caler l'énoncé des étapes d'une recette, simplement en repérant qu'une tâche entamée a été terminée (bruit de couteau, bruit de mixer…).

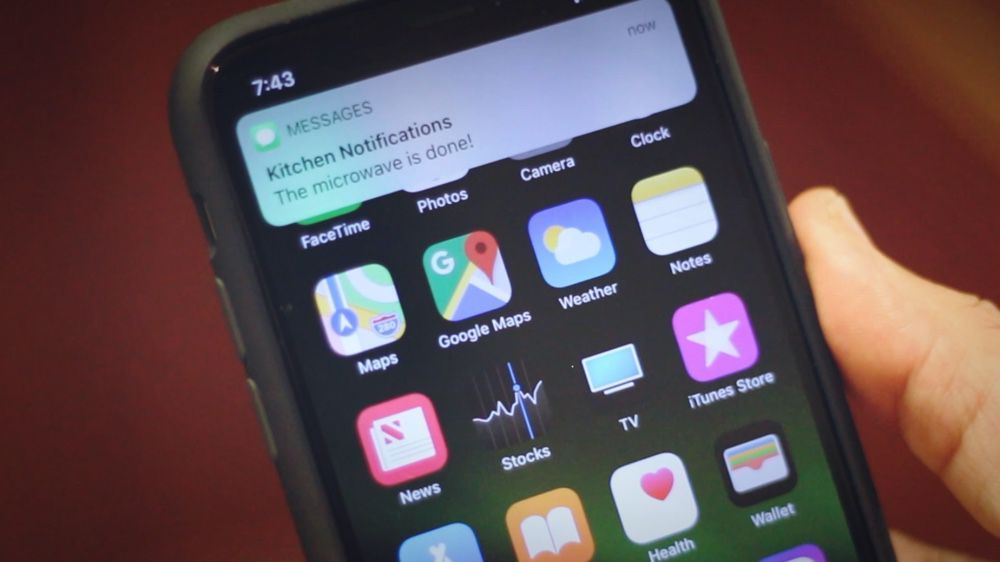

Pour une personne malentendante, le bruit du micro-onde ou de quelqu'un frappant à la porte provoquerait l'envoi d'une notification vers son téléphone.

Au poignet, la captation par votre montre d'une toux récurrente pourrait offrir une information sur votre état de santé. De la même manière que l'analyse d'un mouvement effectué par les capteurs de la montre, associé au bruit provoqué (frapper contre une porte, scier) pourrait participer à améliorer la compréhension future par le système de l'action en cours.

Car le principal challenge consiste justement à identifier ces bruits pour les ranger dans un dictionnaire de sons. Une première méthode consiste à demander à l'utilisateur de répéter une action (comme d'ouvrir une porte) pour entrainer l'oreille du Listen Learner et affecter ensuite un nom. Cela peut donner des résultats précis mais c'est laborieux. Autre approche : l'appareil contenant l'assistant est programmé par défaut avec une large base de sons pré-identifié. Mais il y a le risque que ce ne soit pas assez précis par rapport aux bruits de votre environnement.

La troisième voie consiste à laisser le système apprendre tout seul à repérer des sons caractéristiques, qui se manifestent régulièrement. Avec l'avantage que dans une pièce donnée, il y a tout lieu de penser qu'ils seront en nombre réduit et récurrents.

Lorsqu'un schéma sonore caractéristique commence à se construire, un "cluster" va se former. Lorsqu'il atteint une certaine taille, l'assistant demandera à l'utilisateur de lui donner un nom pour ce profil de bruit qu'il n'a cessé d'entendre.

Pour éviter de sans cesse interpeller l'utilisateur, l'assistant pourrait avoir quelques modèles sonores type préenregistrés et demander plutôt si le bruit en question correspond bien à telle chose, auquel cas on ne répondra que par oui ou non.

Si le système hésite sur un son pouvant appartenir à deux clusters déjà identifié — mettons le bruit d'un sèche-cheveux qui ressemblerait à celui d'un aspirateur — il demandera à l'utilisateur lequel est le bon. Autant de contributions ponctuelles qui viendront renforcer ces clusters de sons.

Plusieurs choses restent sujettes à des difficultés techniques, admettent les chercheurs. La question de la confidentialité des données captées en est une, la puissance nécessaire au traitement en direct de ces infos en est une autre — cela pouvant être fait la nuit lorsque l'assistant est inoccupé — sans oublier la capacité à isoler et identifier un son au milieu de plusieurs.

Source :