Avec les Pixel, Google a réussi à proposer des smartphones parmi les meilleurs en photographie, si ce n’est les meilleurs. Un an après sa sortie, certains journalistes considèrent toujours que le Pixel 2 fait mieux que les iPhone XS, ce qui montre bien au minimum que l’entreprise a réussi à proposer un excellent module photo. On attendait beaucoup du Pixel 3, son successeur présenté cette semaine et Google le savait. Que ce soit pendant sa conférence de présentation ou même sur son site, l’appareil photo est mis en avant en premier, ce qui trahit l’importance de cette fonction.

Contrairement à tous ses concurrents maintenant, Google a opté pour un appareil unique au dos. Là où certains en installent quatre différents, la firme de Mountain View conserve son approche originale, avec un seul objectif et un seul capteur au dos. Le matériel est d’excellente qualité, mais la vraie différence vient du logiciel. Le Pixel 3 compte encore plus que son prédécesseur sur la photographie informatisée (« computational photography ») et c’est sans doute le smartphone qui va le plus loin dans le domaine, bien plus loin que les iPhone de 2018.

Le site spécialisé DPReview a obtenu, outre une galerie de photos, quelques informations techniques exclusives de la part d’ingénieurs Google qui ont travaillé sur le Pixel 3. Ils apportent plusieurs idées nouvelles dans l’univers des smartphones et repoussent encore les limites de ce que la photographie assistée par ordinateur peut faire… on fait le point.

Les mouvements pour améliorer la qualité des photos

Plusieurs nouveautés introduites avec le Pixel 3 dépendent en fait d’une même idée. Comme l’iPhone XS Max, les smartphones de Google prennent en fait plusieurs photos à chaque fois que l’on appuie sur le bouton pour en prendre une. C’est ce qui a permis au géant de la recherche d’introduire le mode HDR+ il y a quelques années, équivalent du Smart HDR d’Apple, et c’est ce qui permet d’obtenir des photos bien équilibrées, même avec des conditions lumineuses difficiles.

Google a conservé ce principe général sur le Pixel 3 et l’a amélioré sur deux points importants. Déjà, le smartphone prend plus de photos à chaque fois, jusqu’à quinze images qui sont combinées en une seule. C’est cinq de plus que le Pixel 2 et six de plus que l’iPhone XS qui compose chaque image de neuf clichés différents au mieux.

La vraie différence toutefois est ailleurs. Le Pixel 3 ne se contente pas de prendre quinze photos en variant les paramètres d’ouverture et de sensibilité, le smartphone profite des mouvements naturels de votre main pour améliorer la qualité de l’image en augmentant le nombre de pixels. Son capteur de 12 mégapixels ne peut pas produire une photo de 20 mégapixels, mais en bougeant légèrement l’appareil photo, on peut gagner des pixels sur tous les côtés. Par ailleurs, cela améliore la qualité en apportant la même quantité de lumière, non seulement à chaque pixel, mais aussi à chaque sous-pixel rouge, vert et bleu qui compose le pixel complet1.

Même si le smartphone est parfaitement immobile, cette technique est utilisée en sollicitant la stabilisation optique. Normalement, la stabilisation permet de compenser un mouvement involontaire en imprimant au capteur un mouvement inverse. Google a détourné cette fonction pour faire varier très légèrement la position du capteur et ainsi obtenir le même résultat : une photo avec une définition légèrement plus élevée, et surtout une meilleure qualité d’image.

Cette technique n’est pas nouvelle et quelques appareils photo la proposent, comme le Sony A7R III ou encore le Pentax K-1. Néanmoins, le Pixel 3 est le premier smartphone à le faire et surtout, Google a amélioré l’idée de base à tel point que la fonction est constamment utilisée. Sur les appareils dédiés, c’était une option, voire un mode spécifique, et il était lié à des contraintes importantes pour obtenir un résultat correct. Du côté de Sony, par exemple, le système consiste en quatre prises différentes, avec une attente d’une seconde entre chaque, ce qui rend l’utilisation d’un pied obligatoire.

Rien de tel sur un smartphone, on s’en doute bien. Google combine nettement plus d’images et tout ce travail est effectué en une fraction de seconde seulement et à chaque fois que vous prenez une photo. Il n’y a pas un mode spécifique à activer et il n’y a aucune condition particulière, il est disponible en permanence pour améliorer chaque photo prise avec le Pixel 3.

Mais en utilisant cette fonction, l’équipe en charge de la photo a trouvé de nouvelles idées pour enrichir l’appareil photo du Pixel 3. En particulier, deux nouvelles fonctions dépendent directement de ce capteur en mouvement : le zoom haute résolution et le mode « Night Sight » pour les photos de nuit. Le premier permet d’obtenir un zoom numérique de bien meilleure qualité, équivalent d’après Google à un zoom 2x optique.

Un zoom 2x, c’est exactement ce que propose Apple avec le téléobjectif de ses iPhone. Le Pixel 3 pourra aller bien au-delà de ce niveau, mais les meilleurs résultats seront obtenus sur les plus petits niveaux de zoom. Sur l’exemple ci-dessus, on voit bien quelques défauts, notamment le long du bras du modèle, mais l’image reste mieux définie qu’un zoom numérique traditionnel. DPReview ajoute que des exemples montrés par les ingénieurs de Google étaient plus impressionnants encore, il faudra voir ce que cela donne à l’usage.

L’autre fonction ne sera pas disponible au lancement du Pixel 3, mais sera activée par une mise à jour ultérieure. Night Sight sera un mode spécifique, qui ne sera activé qu’à la demande et qui nécessite des conditions particulières. Contrairement au fonctionnement normal de l’appareil photo, il nécessite en effet de maintenir le smartphone immobile pendant une seconde ou deux après avoir déclenché.

Tout cela, pour un résultat spectaculaire : des photos dans le noir qui ressemblent à des photos prises en journée. Pour parvenir à un tel résultat, Google exploite la capacité du smartphone à prendre jusqu’à 15 photos pour en créer une seule, mais aussi sur les mouvements du capteur. La différence avec le mode HDR+ qui est actif en permanence, c’est que chaque cliché intermédiaire est pris plus lentement, jusqu’à un tiers de seconde à chaque fois. En les combinant toutes, le Pixel 3 obtient le résultat d’une pose de 5 secondes, mais condensée en un temps nettement plus réduit.

Les algorithmes de fusion de Google se chargent d’éliminer le flou, mais aussi d’éviter les effets d’images fantômes sur les sujets en mouvement. Le rendu final n’est pas forcément naturel, dans le sens où la photo sera plus lumineuse que ce que l’œil humain peut apercevoir. Mais l’idée de l’entreprise, c’est d’offrir une option dans les situations si sombres où l’on ne sortait plus du tout un appareil photo auparavant.

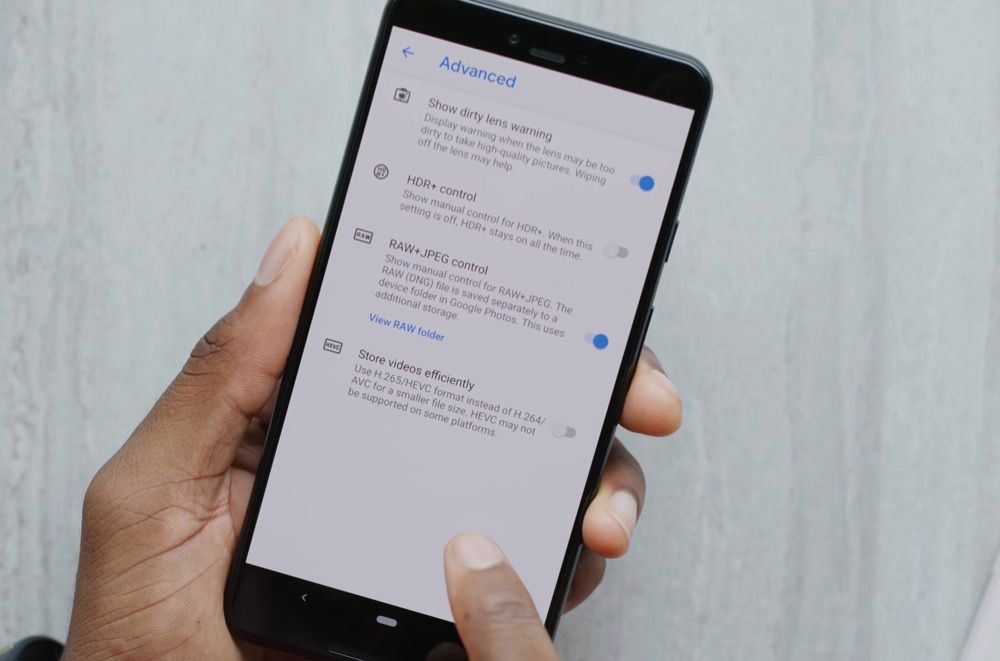

Toute cette mécanique des photos combinées en une et du capteur qui se déplace n’est pas réservée aux JPEG. Le Pixel 3 est le premier smartphone de Google à proposer un mode RAW directement dans l’appareil photo de base. Et contrairement au mode RAW d’un iPhone XS, le rendu n’est pas radicalement différent entre les deux. La firme de Mountain View parle de « computational RAW » et c’est a priori une première dans l’industrie, et pas uniquement pour les smartphones.

Comme pour le JPEG, l’idée est de combiner jusqu’à quinze images en une seule photo et de l’enregistrer en DNG, un standard pour le RAW. Grâce à cet assemblage, Google a de grandes ambitions, puisqu’elle promet des RAW de la qualité d’un reflex équipé d’un capteur APS-C. Pour vous donner une idée, le capteur d’un iPhone XS mesure 40,6 mm², là où un capteur APS-C tourne autour de 350 mm².

Pour le dire autrement, Google a réussi à obtenir la qualité d’un appareil photo dédié avec un capteur de smartphone huit à dix fois plus petit. En tout cas, c’est ce que l’entreprise promet et évidemment, les reflex conservent de nombreux avantages, à commencer par une optique bien meilleure, mais il n’empêche que le Pixel 3 a bien progressé dans ce domaine. Et le smartphone a aussi des arguments à faire valoir, comme sa connexion cellulaire qui permet de partager immédiatement une image, ou encore la possibilité de stocker toutes les photos originales gratuitement sur Google Photos.

L’intelligence artificielle à la rescousse

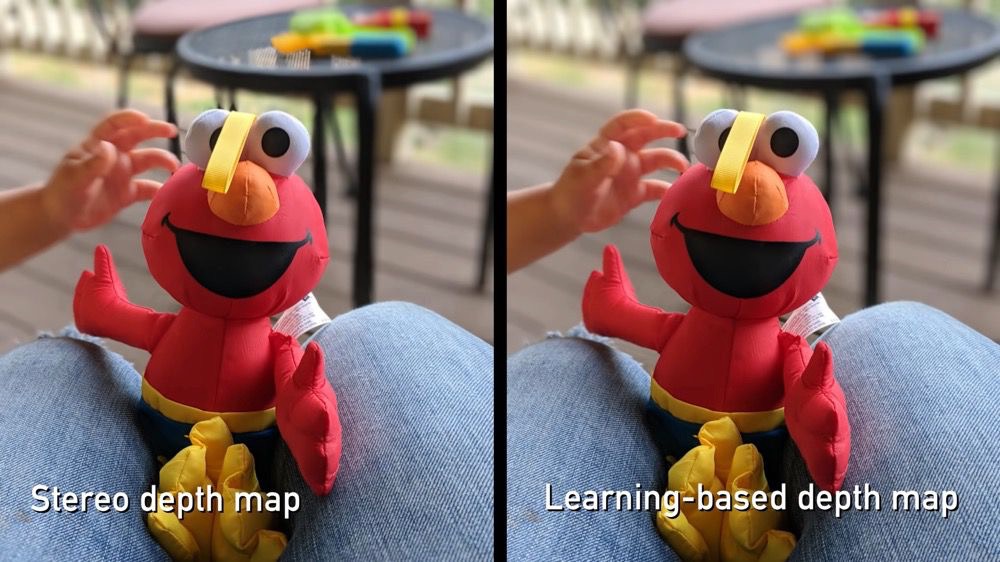

Google a aussi amélioré les algorithmes d’apprentissage automatisé (« machine learning) qui sont également au cœur de l’appareil photo de son smartphone. Ils servaient déjà dans les Pixel précédents, mais leur rôle est plus que jamais prépondérant dans le nouveau modèle. En particulier, le mode portrait repose plus largement sur l’intelligence artificielle pour distinguer les différents plans.

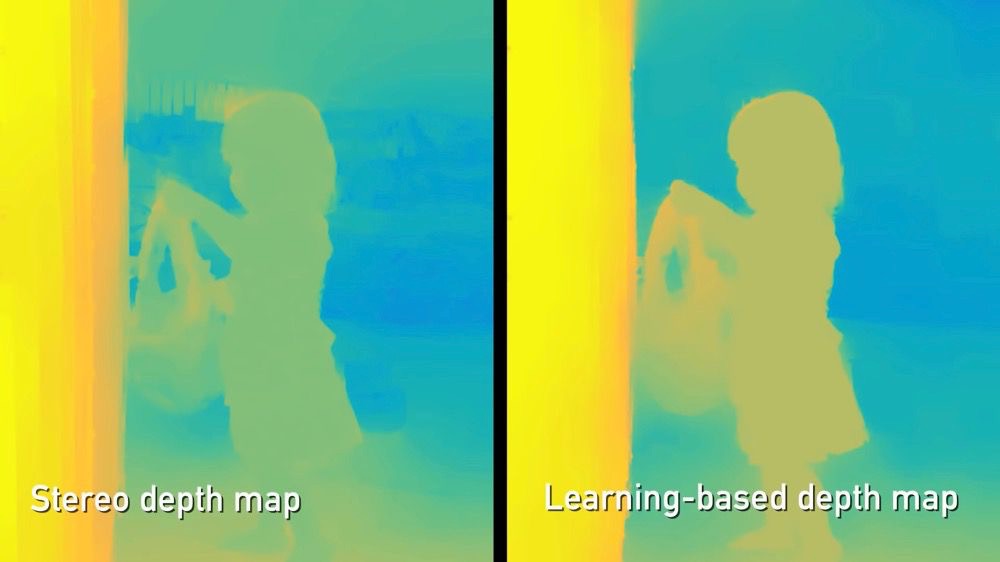

À la base, Google utilise une fonction de son capteur, qui présente des pixels légèrement décalés, pour obtenir une évaluation des distances. C’est ce qu’Apple et tous les autres constructeurs font avec deux appareils photos distincts, mais à une échelle qui ne permet pas d’obtenir naturellement un bon résultat. C’est pourquoi le calcul nécessaire est encore plus important sur les Pixel, et avec cette troisième génération, il se base aussi sur des modèles d’apprentissage pour améliorer le rendu.

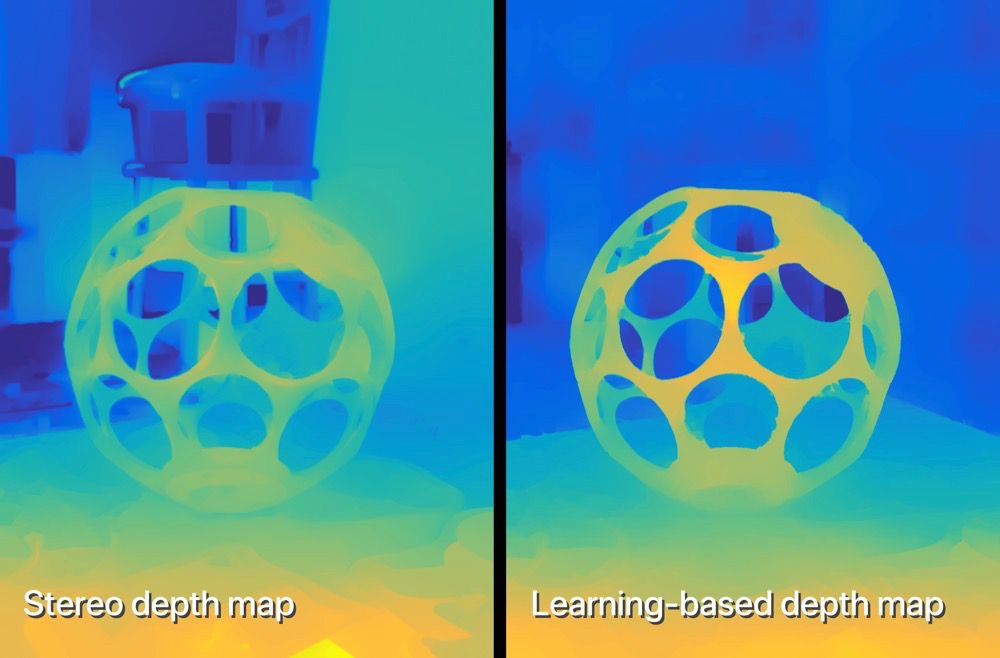

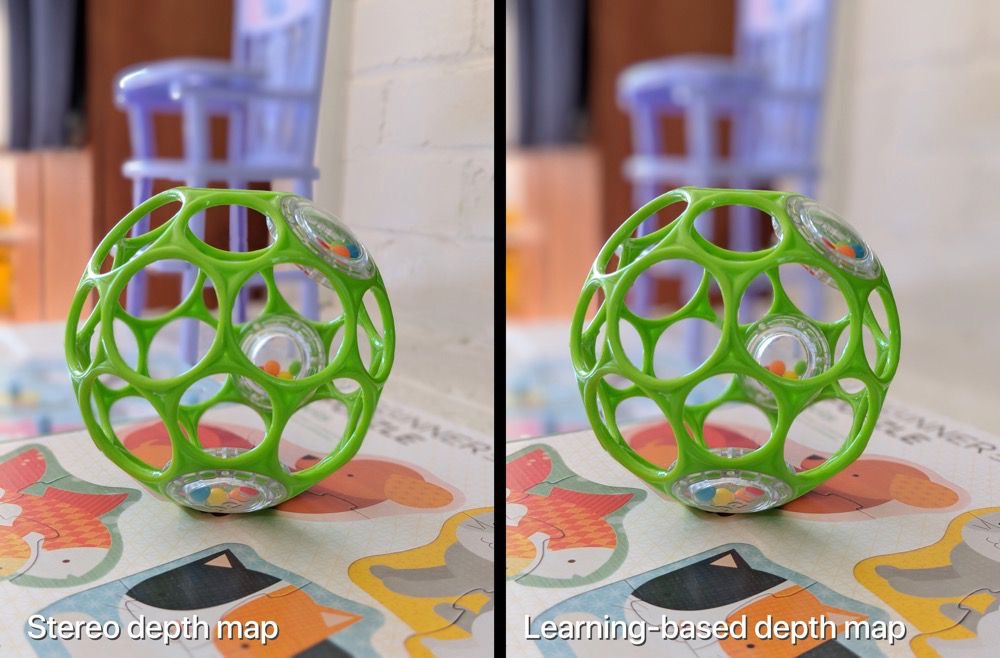

Prenez cet exemple donné par Google. Sur la gauche, vous avez un mode portrait effectué essentiellement à partir du décalage des pixels, avec une carte de profondeur basée sur la stéréoscopie. Sur la droite, le décalage sert toujours, mais il alimente un algorithme de détection qui a identifié le sujet et l’isole mieux de l’arrière-plan. Notez en particulier la barrière derrière l’enfant, elle est parfaitement floue avec l’intelligence artificielle, alors qu’elle est partiellement nette sur l’ancienne version.

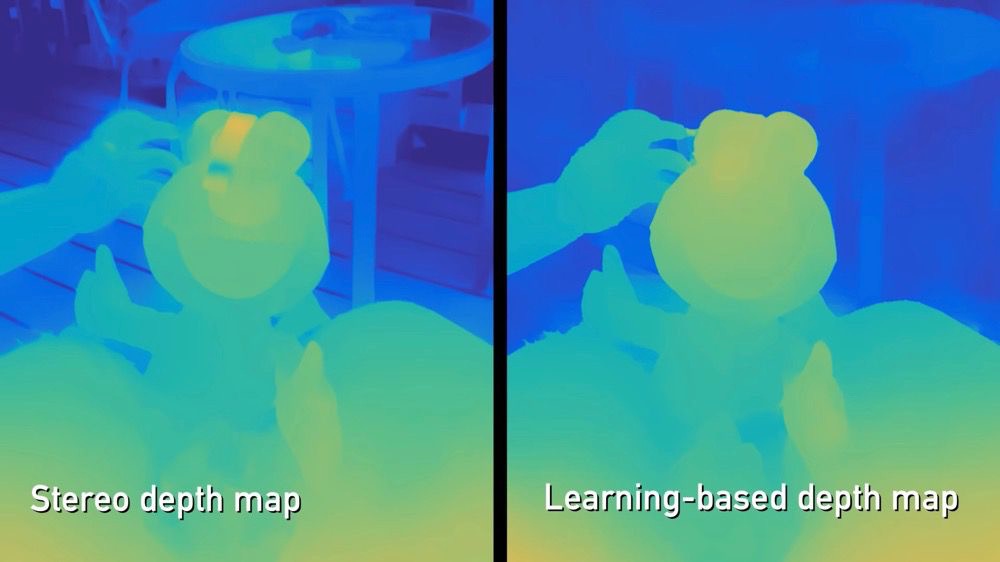

Les algorithmes de Google détectent parfaitement les formes humaines, mais pas seulement. Cet exemple montre aussi que des progrès sont à attendre pour appliquer du flou uniformément sur l’arrière-plan derrière un objet, ou dans les trous entre premier et dernier plan. Notez la différence entre le bras de l’enfant et la cuisse, c’est totalement flou sur la version basée sur les nouveaux algorithmes, plus nette sur l’autre.

On pourrait dire qu’il s’agit toujours de formes humaines, mais ce dernier exemple devrait alors vous convaincre. C’est un sujet très complexe, puisque cet objet troué laisse voir l’arrière-plan, ce qui nécessite un détourage complexe. La version basée sur le décalage n’affiche pas un flou uniforme du fond, celle créée avec l’intelligence artificielle offre un rendu bien meilleur, plus proche de ce qu’un appareil photo dédié pourrait offrir.

Google a aussi repris l’idée de l’éclairage de portrait d’Apple, mais en l’utilisant un petit peu différemment. Pour rappel, l’idée est de simuler l’éclairage que l’on pourrait obtenir dans un studio sur les portraits. Avec les iPhone de 2017 et les suivants, on a quatre éclairages différents sur iOS et on peut passer de l’un à l’autre sur toutes les photos prises avec le mode portrait.

Sur le Pixel 3, il n’y a qu’un seul éclairage, mais il est appliqué systématiquement à tous les visages. Google nomme cette fonction « Synthetic Fill Flash », c'est-à-dire un flash artificiel chargé de « déboucher » les ombres ou de mettre en avant un visage pour un portrait. L’entreprise évoque l’équivalent généré par des algorithmes d’un réflecteur physique, utilisé par les photographes professionnels.

Dans ce cas, l’intelligence artificielle est utilisée pour distinguer les visages du reste — c’est le même mécanisme que pour le mode portrait — et pour modifier leur éclairage. Les traitements ajoutent un petit peu de luminosité pour simuler un flash sans avoir à utiliser le flash physique présent au dos du Pixel 3. Cela fonctionne aussi bien avec la caméra arrière, que les deux devant.

Ce même mécanisme sert aussi à une nouvelle fonction de stabilisation vidéo sur la caméra avant. Le Pixel 3 analyse le flux vidéo et détecte les visages sur chaque image, pour garder la mise au point sur lui, plutôt que l’arrière-plan ou un autre objet. Cette nouvelle stabilisation réduit la taille de la vidéo, mais elle permet apparemment d’obtenir un rendu beaucoup plus fluide.

Pour finir sur le chapitre de l’intelligence artificielle, notons qu’elle sert encore pour les photos de nuit avec le mode « Night Sight ». Google utilise ses algorithmes avancés pour la balance des blancs, puisqu’il n’y a plus assez de lumière pour un mode automatique traditionnel. Le Pixel 3 va essayer d’estimer la meilleure balance des blancs pour obtenir un rendu aussi réaliste que possible… il faudra voir ce que cela donnera en conditions réelles.

L’intelligence artificielle est au cœur de l’expérience et nous n’avons pas encore évoqué tous les cas de figure où elle est utilisée dans l’appareil photo du Pixel 3. La fonction « Meilleur cliché » qui suggère une meilleure photo dans la demi-seconde qui précède et qui suit la prise2 est basée entièrement sur des algorithmes chargés de vérifier si le sujet sourit, s’il ferme les yeux, etc. Même chose pour la mise au point intelligente, capable de suivre une personne en mouvement, ou même un objet, si vous le sélectionnez sur l’écran.

Les tests du Pixel 3 n’ont pas encore été publiés, nous ne savons pas encore ce que vaut cet appareil photo hors d’un environnement contrôlé par Google. Néanmoins, ces premiers éléments sont prometteurs et on voit que l’entreprise continue d’innover dans ce domaine. Apple a fait un grand pas en avant cette année en matière de photographie, mais ça ne sera peut-être pas suffisant pour tenir la distance…

-

Le Pixel 3 n’a plus besoin de passer par l’étape de dématriçage, ce qui améliore mécaniquement la qualité des images. ↩︎

-

Au passage, les ingénieurs de Google ont indiqué que la qualité de cette photo serait inférieure à l’originale, mais suffisamment bonne pour que la différence ne se voit pas. On verra si c’est bien le cas, mais on imagine/espère que la perte de qualité sera inférieure à celle que l’on connaît sur iOS, quand on change la photo principale d’une Live Photo. ↩︎