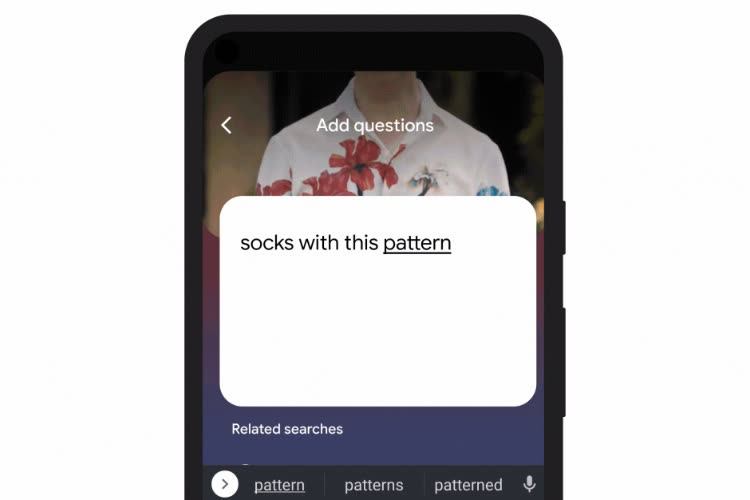

Google continue d'améliorer Google Lens, son service de reconnaissance par image directement incorporé à l'application Google sur iOS. Prochainement, on pourra effectuer une recherche basée sur une image et des mots-clefs. Imaginons que vous cherchez la référence d'une chemise blanche que vous avez en photo dans votre pellicule. Vous envoyez le cliché, et Google va vous remonter le modèle exact. Avec cette nouveauté, il va être possible de donner des précisions textuelles : en tapant « bleu », vous aurez le même modèle, mais dans un coloris différent. Cette petite vidéo montre bien comment le tout va fonctionner :

Google précise que l'on pourra utiliser directement l'appareil photo de son téléphone afin de prendre une photo depuis l'app. L'entreprise donne quelques scénarios dans lesquels cette fonction sera pratique, comme pour avoir des conseils sur l'entretien d'une plante photographiée ou encore pour obtenir facilement la référence d'une table basse qui s'accorderait bien avec le reste du salon.

La fonction est disponible en bêta aux États-Unis sur Android et iOS. L'entreprise précise que les recherches de shopping sont celles qui obtiennent les meilleurs résultats. Rappelons que Google image propose déjà la recherche par photo : en envoyant une image, les algorithmes peuvent repérer les objets et vous faire remonter leurs références en un clin d'œil. Depuis l'année dernière, il est même possible d'effectuer une recherche mélangeant mots-clefs et certains éléments d'un cliché, comme un t-shirt orné d'un motif qu'il est bien difficile de décrire avec des mots, mais que vous voyez sur une photo.