Apple va avoir beaucoup de travail pour expliquer et tenter de rassurer autour de sa solution de détection de photos pédopornographiques. Plusieurs organisations et personnalités sont vent debout contre ce qui est présenté comme un système de surveillance global (lire : Les nouveaux systèmes d'Apple pour lutter contre la pédopornographie inquiètent).

Will Cathcart, le patron de WhatsApp, met les deux pieds dans le plat dans un fil Twitter : il n'est pas question d'implanter un système similaire dans l'application de messagerie instantanée appartenant à Facebook. Il compare la technologie du constructeur à un « système de surveillance construit et opéré par Apple qui pourrait facilement être utilisé pour examiner du contenu privé en fonction des exigences d'un gouvernement ».

Le dirigeant s'interroge sur la gestion par Apple des requêtes des gouvernements qui voudront ajouter d'autres types de contenus que la pédopornographie. Et que se passera-t-il si une société spécialisée dans les spywares dégottait une faille dans l'armure ? Cathcart se demande également pourquoi le constructeur n'a pas travaillé avec des experts dans ce domaine (sur le site web de présentation de ces mesures, Apple partage quatre analyses techniques provenant de trois chercheurs).

L'approche d'Apple dans ce dossier pose de sérieux problèmes, selon lui, « plutôt que de se concentrer sur une manière facile pour les utilisateurs de signaler du contenu partagé avec eux, Apple a construit un logiciel qui scanne toutes les photos privées que vous ne partagez avec personne. Ce n'est pas de la confidentialité », reproche-t-il.

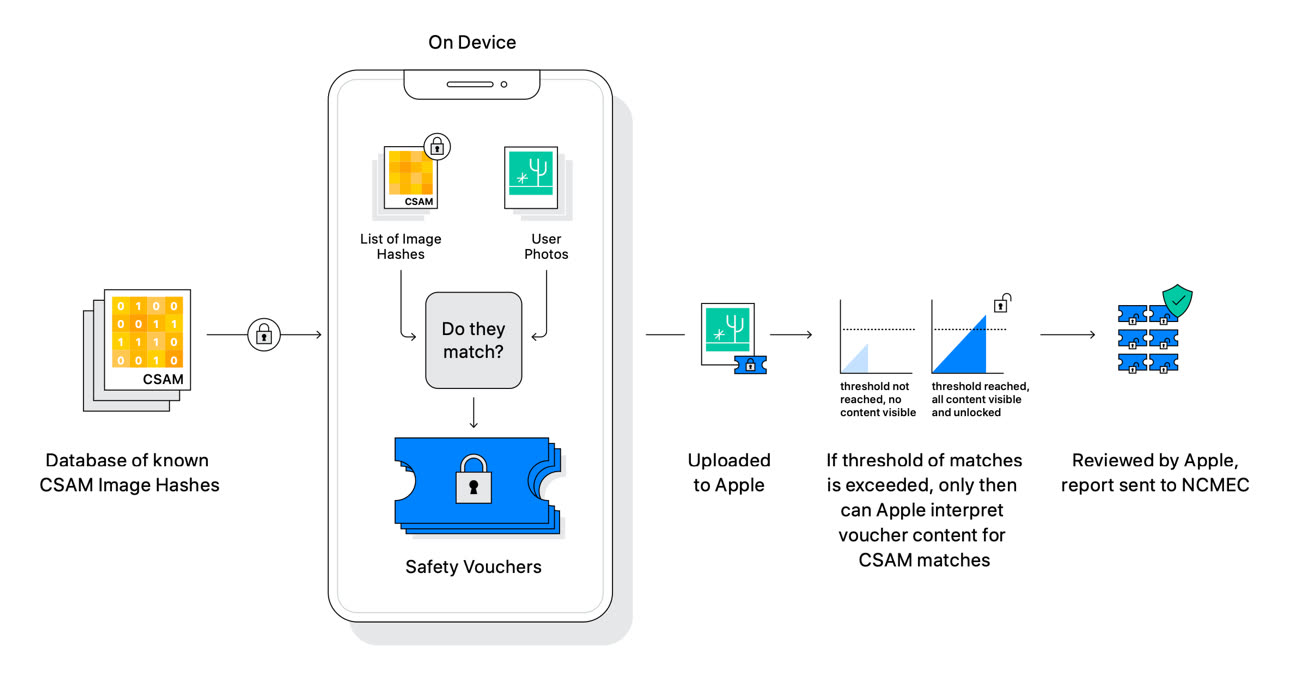

Le mécanisme de détection des images CSAM (Child Sexual Abuse Material) repose sur un mécanisme de correspondance entre une base de données d'images pédopornographiques et les photos de l'utilisateur. Plus précisément, il s'agit de comparer des suites de chiffres : les images sont converties par l'iPhone en des numéros hachées par un processus cryptographique (baptisé NeuralHash).

Ce processus de comparaison est réalisé sur l'appareil en local, avant que les images soient téléversées dans la bibliothèque iCloud Photos de l'utilisateur. En cas de correspondance avec la base de données, la photo uploadée s'accompagne d'un « bon de sécurité » qui encode le résultat de la correspondance. À partir d'un certain nombre de correspondances, Apple peut déchiffrer le contenu du bon de sécurité, une opération qui est ensuite visée par un opérateur humain.

WhatsApp a mis en place un système de signalement qui a permis de rapporter plus de 400 000 cas l'an dernier au NCMEC (National Center for Missing and Exploited Children) , « sans casser le chiffrement », s'enorgueillit Will Cathcart.

Photos, Messages : Apple dévoile de nouveaux mécanismes pour lutter contre la pédopornographie