Microsoft présente Phi-3, un petit modèle d’IA prometteur pouvant tourner en local sur un iPhone 14

La sortie de ChatGPT vous a peut-être rendu familier avec le concept de LLM, ces Large Language Model capables de générer du texte et de donner la réponse la plus probable à une requête. Mais il existe également des déclinaisons plus petites baptisées SLM (Small Language Model), que l’on connaît bien dans l’écosystème Apple étant donné que l’un d’entre eux carbure sous le clavier de Sonoma et d’iOS 17. Microsoft n’est pas en reste et a récemment levé le voile sur Phi-3-mini, un modèle similaire présenté comme « les plus performants et le plus rentable du marché ». Sa petite taille lui permet de tourner facilement en local sur un ordinateur, et même correctement sur un smartphone.

Phi-3-mini est un petit modèle à 3,8 milliards de paramètres, prochainement décliné en plusieurs variantes plus grosses. Malgré sa petite taille quand on le compare aux mastodontes du domaine, Microsoft assure que son produit propose des performances pouvant rivaliser avec la concurrence, citant entre autres GPT-3.5. Le chercheur spécialisé Simon Willison a pu jouer avec avant de partager son expérience à ArsTechnica. Il explique que le modèle peut tourner à une vitesse convenable sur un appareil avec 8 Go de RAM et un CPU standard. « Il devrait fonctionner correctement sur un Raspberry Pi à 55 $ et la qualité des résultats que j'ai pu observer jusqu'à présent est comparable à des modèles quatre fois plus grands », ajoute-t-il.

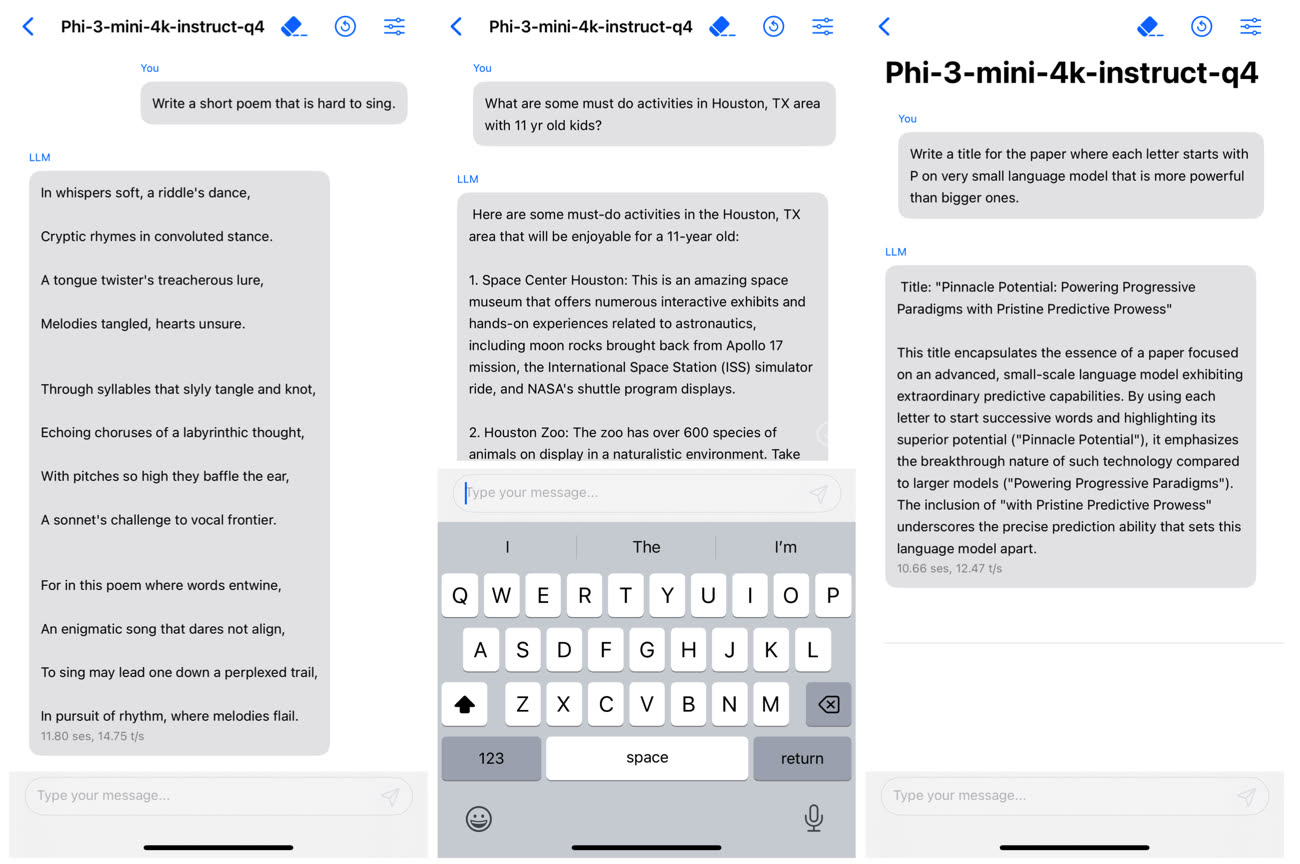

Dans leur papier de recherche, ses créateurs expliquent l’avoir fait tourner sur un iPhone 14 embarquant la puce A16 Bionic. Le modèle a réussi à générer 12 tokens par seconde, ce qui est plus qu’honorable.

Pour obtenir de telles performances, Microsoft a entrainé son IA sur des données de très haute qualité reprise de manuels scolaires et de contenus soigneusement sélectionnés. L’idée serait de pouvoir proposer une alternative aux grosses machines comme GPT-4, pouvant tourner localement et sans connexion dans le nuage. Une limitation du modèle vient de ses connaissances restreintes par rapport aux concurrents plus imposants, mais ce point n’est pas forcément primordial pour toutes les tâches confiées à un LLM. Phi-3 peut être téléchargé via le service de Cloud Azure, mais aussi depuis la plateforme HuggingFace et Ollama.

Exécuter un grand modèle de langage sur son iPhone, c’est déjà possible

Ce n’est pas la seule sortie de Microsoft côté IA cette semaine. L’entreprise a également publié WizardLM2, un modèle open source présenté comme très puissant. Seul problème : il a été supprimé quelques heures après sa mise en ligne, Microsoft ayant visiblement oublié l’étape du « test de toxicité ». Difficile de savoir si celui-ci est complètement non censuré et potentiellement dangereux, mais on devrait le savoir assez vite étant donné que de multiples copies sont désormais dans la nature.

J’en profite, est-ce que quelqu’un connaît une app sur iPhone façon chatGPT qui permet d’utiliser les api d’openAI et openRouter ?

J’ai testé une application sur iPhone de LLM local ça ne parle pas français de base ( il faut le mentionné dans un prompt ) et ensuite ça englouti 1% de batterie pratiquement par réponse

Et en plus je suis iPhone 15P avec donc 8GB de RAM !

Si quelqu’un connaît une bonne application qui fonctionne sans défoncé la batterie je suis preneur 😈

Édit : c’est là que je me dis que Apple a un coup à jouer avec un LLM local qui fonctionne bien et n'est pas énergivore.

@R-APPLE-R

Ça rejoint la question que je posais l’autre jour. Le « tout en local » c’est bien mais niveau autonomie est ce qu’un système sur serveur ne serait pas plus intéressant quand même ?

@cecile_aelita

L’innovation de MS ici c’est d’avoir des modèles presque 2x plus petit, et donc consomme moins de ressources.

Ensuite, il faut attendre iOS 18. Il y a fort à parier qu’on aura une belle optimisation logicielle pour avoir des inférences optimisées.

@Ensearque

Regardez ma réponse juste au dessus 😈

@Ensearque

Pas d’après le retour d’expérience de R-APPLE-R 🙂

@R-APPLE-R

Euh… Intérêt sur un phone?

@0MiguelAnge0

La vie privée ? 😈

apparemment M$ vient d'apporter la réponse 😉

@appleadict

Non car les modèles que j’ai essayé sont aussi petit que ceux de Microsoft, 3,8 milliards de paramètres donc non

De toute façon vous ne pouvez pas dépasser les 4 milliards de paramètres avec 8GB de RAM c’est trop lent après 😈

Nvidia doit s’inquiéter ?

@abalem

Je ne pense pas, MS à aussi annoncé que le modèle est peut troué et en local sur des PC équipe de GPU NVidia

Apple vient aussi de sortir OpenELM une famille de petits modèles open-source

J’attends phi mo-6 qui sera vraiment tout petit.